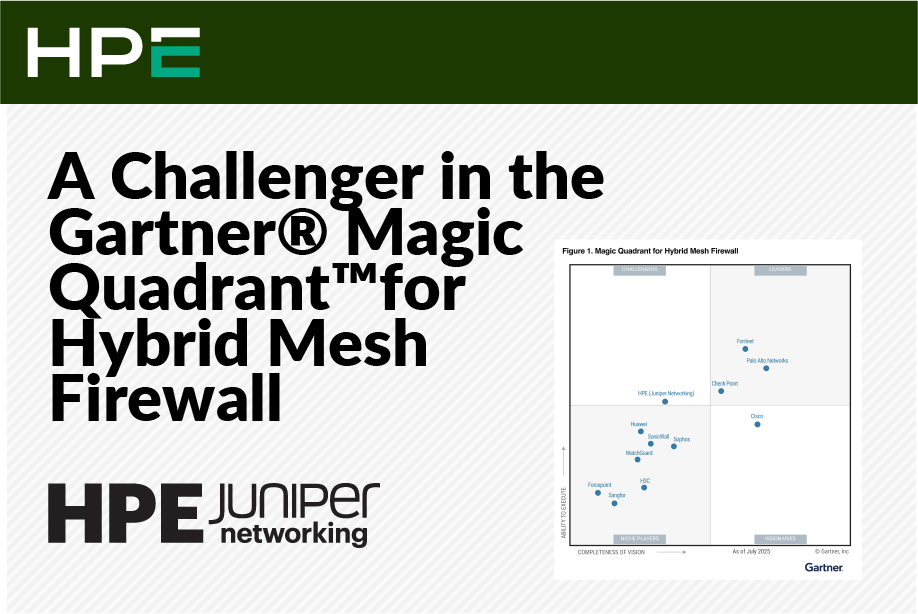

HPE Juniper Networkingがチャレンジャーの1社として位置づけられたことで、安全なAIネイティブネットワーキングプラットフォームの価値が明らかとなったと考える理由をお話しします。 サイバーセキュリティ環境が進化を続ける中で求められるのは、テクノロジーのイノベーションだけではありません。エンタープライズインフラストラクチャのファブリックにそのテクノロジーがどのように組み込まれるかについてのイノベーションも求められます。大手の独立系業界アナリスト企業レポートの1つであるGartner Magic Quadrantにおいて、2025年、重要なリソースとしてHMW MQが登場しました。とりわけ、HPE Juniper Networkingがチャレンジャーの1社に位置づけられたことは、競争の激しい市場において当社のアーキテクチャに関するアプローチの強みが認められたことを示しており、また今年の夏に完了したHPEによるジュニパーネットワークスの買収によって市場が拡大することを考慮すると、まだまだ成長の余地があると確信しています。 Gartnerのハイブリッドメッシュファイアウォールを対象としたMagic Quadrantについて Gartner Magic Quadrantは、ITリーダーがテクノロジーベンダーを評価するうえで、1つの有力な視点を提供します。このMagic Quadrantでは、ハードウェア、仮想、クラウドの導入環境全体にわたるクラウドベースの統合管理を提供する、ハイブリッドメッシュファイアウォールを分析します。 Magic Quadrantでは、ベンダーの「ビジョンの完全性」と「実行能力」が評価されます。この点において、ジュニパーはチャレンジャーの1社として評価されました。そのように評価された理由は正当なものであると確信しています。 HPE Juniper Networkingをチャレンジャーの1社に位置づけ Gartnerのハイブリッドメッシュファイアウォールを対象としたMagic Quadrantで唯一のチャレンジャーとして位置づけられたのは、当社の継続的な取り組みとイノベーションが評価されたためであると考えています。当社にとって今回の位置づけは、優れた実行力とサポートとなる運用能力、堅牢なソリューションを提供してきた実績、このカテゴリーの将来を形作る潜在能力を証明するものです。 ジュニパーネットワークスは、Altor買収後の2010年に市場初の仮想ファイアウォールを、2018年には業界初のコンテナ型ファイアウォールを実現し、Gartnerがこのカテゴリーを定めた2022年より前の2019年には、HMFの早期のソートリーダーとなっており、セキュリティ有効性というパフォーマンスにおいて常に業界のトップを維持しています。 この評価は当社にとって特に重要なものであり、堅牢なネットワークインフラストラクチャプロバイダから真のセキュリティイノベータへと進化したことを証明するジュニパーのアーキテクチャに関するアプローチが、計画的な歩みであったことを示しています。ジュニパーがチャレンジャーの1社に位置づけられたことは、当社のアプローチが単なるセキュリティツールの寄せ集め以上のものを求める企業の共感を集めた証です。 安全なAIネイティブネットワーキングプラットフォームというアプローチ ジュニパーのアプローチの中核を成すのは、AIネイティブネットワーキングプラットフォームと統合型セキュリティへの取り組みです。ジュニパーは、レガシーフレームワークに新たな製品を積み重ねていったり、買収のみで成長を達成しようとするのではなく、ネットワーキングとセキュリティの両方の要素から得られたテレメトリを活用する、適応性に優れた統合ソリューションスイートを構築することに重点を置くことで、環境全体の保護を強化してきました。HPE Juniper Networkingのアーキテクチャは、組織とともに成長するように設計されており、シンプルなモジュール型で緊密に相互接続されています。 このアプローチが説得力を持つのは、以下の理由からです。 包括性とシンプルさ:ジュニパーは、機能を後付けで揃えて組み合わせるのではなく、Junos

ここ数年、無線ネットワークに関するトップレベルの話し合いは、予測可能なスクリプトに沿った内容のものでしかありませんでした。ネットワークは予算項目であって、ビジネスを遂行するうえで必要なコストと考えられており、多くの場合「可能な限り低コストで最高のパフォーマンスを得るにはどうしたらよいか? 」という1つの問いでアプローチされます。 この古い考え方により、企業は妥協のサイクルに囚われ、誤った選択を強いられることになります。それは、企業全体で高級な高密度のハードウェアに過剰な投資をするか(極めて非効率的な資本配分)、「まあまあの」ソリューションを選択して重要な環境においてネットワークが絶えずイライラの原因になることを受け入れるかのどちらかです。その結果でもたらされるのは、イノベーションの停滞、不満を抱く従業員、絶えず障害対応チケットに追いたてられ疲れ切ったIT運用チームです。 このような形で資金を管理したくはないでしょう。すべての資金を1つのリスクが高い株に投資するのは悪しき慣例です。また、低利回りの貯金口座にすべての資金を置きたくもないでしょう。リターンを最大化し、リスクを最小限にするには、ポートフォリオを多様化させ、適切なアセットを適切な場所に配分するべきです。 今こそ、無線インフラストラクチャにも同様の戦略的な規律を適用すべきときです。ネットワークはコストセンターではなく、生産性、イノベーション、収益を直接高めることができるアセットのポートフォリオです。ハイブリッドワークが当たり前の時代において、IoTドリブンの運用、主流となるエンタープライズAIの導入、強力で耐障害性に優れたネットワークはもはや不可欠です。これは、すべての戦略的イニシアチブを支える基礎となる投資です。 多様な無線ポートフォリオを構築する ジュニパーは、この新たな現実に対するソリューションを設計しました。最新のネットワークポートフォリオには、特定のビジネス成果を得るために設計されたさまざまなクラスのアセットが必要です。企業の全部門にわたって価値を高めるには、財務ポートフォリオのバランスを取るのと同様、テクノロジーアセットのバランスを取る必要があります。 主力のアクセスポイント(AP47):高パフォーマンスのコア どのポートフォリオにも、高成長エンジンが必要です。当社の主力製品であるAP47はまさに、イノベーションとエクスペリエンスが最も重要とされる、要求が非常に厳しくリスクの高い環境向けに設計されたアセットです。エンジニアが膨大なデータセットを元に作業するコラボレーション研究開発ハブや、没入型のデモンストレーションを行うエグゼクティブブリーフィングセンター、次世代の教育エクスペリエンスを提供する教室を想定しています。AP47は、当社の最も高度なWi-Fi 7アクセスポイントであり、マルチリンクオペレーションや6 GHzなどのテクノロジーを利用しています。極めて要求の厳しいアプリケーション、ビデオ会議、リアルタイムデジタルツインに不可欠な、かつてない高速性と超低遅延を実現します。これは、トップラインのパフォーマンスと将来性を考えた投資です。 新パフォーマンスアクセスポイント(AP37およびAP36):拡張可能でエクスペリエンスファーストのWi-Fi 信頼性の高いポートフォリオの中核であり、広範さと一貫性に重点を置いて構築されました。当社のパフォーマンスアクセスポイントであるAP37およびAP36は、日々ビジネスが行われる企業の大半を占める箇所(会社のオフィス、教室、小売店などを想定)を強化するために設計されました。最新の職場において、ユーザーエクスペリエンスこそがネットワークです。これらのAPは、ジュニパーのWi-Fi 7のエクスペリエンスファーストの原則を日々の運用に取り入れることで、Microsoft Teams®やZoom®などの重要なコラボレーションツールが完璧に動作し、クラウドアプリケーションが即座に応答し、従業員が中断することなく生産性を維持できることを保証します。この投資では、従業員の効率性や満足度という形で高品質のリターンを手に入れることができます。 耐久性に優れた屋内または屋外用の新アクセスポイント(AP66):運用エッジに価値を拡大 真に完全なポートフォリオは、環境の整ったオフィスで停止することはありません。当社の耐久性に優れた屋内または屋外用アクセスポイントであるAP66は、ビジネスが物理的価値を生み出す難易度の高い環境にまで、高パフォーマンスの接続を拡張するために設計されています。倉庫フロア、製造ライン、物流ヤードは、サプライチェーンの重要な中心部分です。これらの空間で接続が切れると、不便であるだけでなく、出荷が止まったり、製造ラインが停止したり、安全上のリスクが発生したりします。AP66は、AGV(無人搬送車)、リアルタイムインベントリスキャナー、AR支援メンテナンスシステムに電力を供給するために必要な堅牢な接続を提供することで、運用効率を直接的に改善し、サプライチェーン全体の耐障害性を強化します。 AIネイティブネットワーキングプラットフォーム:Mist ワールドクラスの一連のアセットは、それを管理するプラットフォームと同様、優れています。無線ポートフォリオ全体が、ジュニパーのAIネイティブネットワーキングプラットフォームであるMist™によって管理され、リアルタイムのクラウドベースのマイクロサービス上に構築されており、それによって比類のない俊敏性と拡張性が提供されます。また、一連のハードウェアは自動運転システムに変換されます。面倒な手作業を事前対応型のAIネイティブの自動化に置き換え、SLE(サービスレベル期待値)メトリックを通じてユーザーエクスペリエンスをこれまでにないレベルで可視化します。データの海に溺れてしまう代わりに、Marvis® AIエンジンが回答を提供してくれます。根本的原因を特定してくれ、是正措置を推奨および実行します。これにより、IT運用チームは障害対応に追われる代わりにイノベーションの推進に時間を割り当てることができ、基本的に運用コストを下げることができます。 賭けをヘッジする:新しいMist Edge ME-X2-Mで重要なサイトの稼働を維持 主力店舗や配送センター、キャンパスがオフラインになると、売上が止まり、運用が滞り、信頼が失われます。ジュニパーの新たなMist Edge ME-X2-Mは、ミッションクリティカルな場所での自給自足的な対応を可能にすることで、こうしたリスクからお客様を保護します。 クラウドやデータセンターとの接続が中断しても、重要なオンサイトサービスは稼働し続けます。取引は処理され、通話や会議は継続され、スキャナーやバッジリーダーはオンライン状態のままで、Wi-Fiへのアクセスもシームレスに維持されます。ダウンタイムはなく、大変な事態が起きることはありません。 制御に注力し、「もしもの場合に備えて」容量をアイドル状態のままにしている従来の無線コントローラとは異なり、Mist Edgeは、日々高い生産性を維持し、必要な際の準備は万全の、常時稼働の保護を提供します。Mist Cloudを通じてシンプルに展開、管理でき、場所や要件の拡大に合わせて拡張するのも容易です。 実現できること: ビジネス継続性:アップストリームの障害中でも運用が継続

HPE NetworkingのチーフAIオフィサーであるボブ・フライデーと私は、最近、Tech Field Dayのポッドキャストに参加しました。このポッドキャストの出発点となる前提は、「データセンターネットワークにはAIが必要」というテーマでした。私たちはこれに完全に同意しています。この2部構成のブログシリーズのパート1では、AIを使用するか否か、またAIをどのような方法で使用するかに関する議論は、特定の目標と、現在直面していて解決の必要がある問題に基づいて行われる必要があることを強調しました。データセンターネットワークの運用担当者が抱えている課題を検証した後であれば、AIが実際に役に立つことは明らかです。どのように役に立つのかについて、以下で説明します。 AIネイティブのイノベーションがデータセンターのリーダーシップを拡張 AIの性能の改善は急速に進んでいるため、Day 0の設計、Day 1の導入からDay 2の継続的運用に至るデータセンターのライフサイクル全体で、AIが占める役割は疑いなくますます大きくなっています。私たちは先日、データセンターネットワークのための新しいAIOps機能をいくつか発表しました。 予測メンテナンスにより、ネットワーク運用担当者は、将来発生するかもしれない問題を特定し、実際に発生する前にその問題を解決できます。 システム正常性プロセッサーとメモリの使用率や温度などの分析データに基づいて、スイッチで障害が発生する時期を予測します。 容量リンク使用率やトラフィックの増加などのデータに基づいて、ファブリックの拡張が必要になる時期を予測します。 光インターフェイスTx/Rxのスループット、電力、電圧などに基づいて、光トランシーバで障害が発生する時期を予測します。光インターフェイスのグレー障害は常に問題であり、完全な障害よりも深刻な(検知しにくい)場合があります。 こうした例の多くで、最初に提供された時点では、この機能は動的で応答的な形でAIを使用していません。当初は多くの場合、システムはアラームをトリガーする静的なしきい値を設定しています。しかし、良いブドウが良いワインを作るように、優れたAIを作るのは優れたデータです。データの蓄積には相応の時間がかかり、ジュニパーが競合他社と比べて優位性を持っている理由はそこにあります。ジュニパーはMist®プラットフォームで10年以上かけてAIOpsを実施してきました。優れたAIはデータを蓄積し、学習とトレーニングを繰り返し、適応するための時間を必要とします。このようにして、ユーザーエクスペリエンスの最適化という目標に到達します。データセンターでは、AIOpsはいまだに成長初期の段階ですが、その改善はきわめて迅速に進んでいます。 サービスレベル期待値が設定されていると、広範なネットワークパラメーターの合算処理、総括的な健全性メトリックの算出、特定の時期のこれらのメトリックに影響を与える問題の分析を行う必要が出てきます。その結果、お客様は、ネットワークがアプリケーションオーナーやエンドユーザーのニーズを満たしているかどうかを明確に把握できるようになります。 ドキュメントのクエリは、仮想ネットワークアシスタントの典型的な基本ユースケースです。多くのインフラストラクチャベンダーがまずこれから始めて、LLMを製品ドキュメントに関連付けて検索の精度を高めようとします。LLMを実際のエンタープライズソフトウェアアプリケーションに関連付けたり、当社の事例であれば、ネットワーク管理および自動化ツールに関連付けたり、アクセス可能な大量のデータに関連付けるなど、より高度な使い方をするようになります。ネットワーク運用担当者は、現在の方法よりも優れた、新しい別の方法(自然言語を介す方法)でツールを操作できます。AIアシスタント「Marvis™」により、私たちはビジネスにおいて最高のサポートを提供できます。 アプリケーションアシュアランスは欠かすことができません。アプリケーションをホストしてエンドユーザーに提供することが、データセンターのまさに核心だからです。当社のソリューションは、AIOpsとインテントベースネットワーク構築を結び付けます。トラフィックフローが正常な状態でない場合、異常検知アルゴリズムによって検知されます。特定の時刻にどのアプリケーションのフローがどのポートを経由して行われているかという決定論的な把握に、こうしたインテリジェンスが結び付けられ、ネットワーキングとアプリケーションのパフォーマンスがひとまとめにされます。 そして、おそらくこれが最も重要な点ですが、データセンターにおけるAIOpsの最終的なカテゴリーは、単純に「実験」です。LLM(大規模言語モデル)は、ほとんど魔法のような驚くべきメカニズムです。このモデルを構築した人たちは、このモデルが動作する仕組みの背後にある直感能力のようなものを、必ずしも理解していないことを認めるでしょう。 エンタープライズビジネスの変革を広い意味で捉えると、すべての企業が基本のLLMを取り込み、これに調整を加えているといえます。企業は自分たちの手元にある企業データという宝の山をベクトル化し、RAG(検索拡張生成)を通じてAIモデルに取り込ませています。ソフトウェアを販売している企業はすべて、自社のソフトウェアをLLMや他のAIモデルに結び付けるという実験を進めているといえます。ネットワーキング業界寄りである当社は、MCP(Model Context Protocol)がエージェント型AIの主要なファシリテーターであると想定しています。エンタープライズソフトウェア用にMCPサーバーを構築していないのであれば、今すぐ構築してください。 今後数年間で進む相当数のAIイノベーションが、お客様主導になると考えられます。ベンダーがオープンシステムをお客様に提供することで、驚くような、想定外の結果がもたらされる可能性があります。企業の歴史全体を通じて、多くの業界がサプライヤではなくエンドユーザーによる革新的なイノベーションによって変革を遂げてきました。 刺激的な時代に生きる 私たちの多くは世の中に流布するAIに関する情報の山に埋もれており、その情報が飛び交うスピードに圧倒されています。最新情報を常に把握したいとは考えていますが、圧倒されたくないと思っています。とはいえ、AIはかつてないほど手に入れやすく身近なものとなっています。誰もがHugging Faceから無数に存在する利用可能なAIモデルを無料でダウンロードできます。初心者でも容易にMCPサーバーを構築して、多数のデータソースに接続できます。そして、何かの問題で行き詰ったら、Claudeにサポートをお願いできます。LLMは、まるで対話可能な実在の人物のように思われ始めています。ネットワークエンジニアにとっては、本当に刺激的な時代です。

当社がAIネイティブネットワーキングのパワーについて話すとき、単にデータセンターやキャンパスについて話しているのではありません。場所を問わず比類のないユーザーエクスペリエンスを実現するということを話しています。そしてその歩みはブランチネットワークから始まります。Self-Driving Networkが登場したことで、このビジョンは現実のものとなりました。当社の新しいセッションスマートルーター、SSR400は、AIネイティブで自動運転のSD-WANが分散型の企業環境でフルに活かされるように設計されており、これまでにない運用の簡素化、パフォーマンス、セキュリティを実現します。 10年以上にわたり、当社はお客様よりご意見をいただき、エンドユーザーからクラウドまでのミッションクリティカルなネットワークを提供することに関して信頼をいただいています。こうしたお客様との歩みの中で、当社は無線、有線、SD-WANの全体にわたって迅速に革新を進めながら、日々お客様の期待を超えるよう取り組んでいます。SSR400シリーズは現在当社で最も革新的な製品であり、SD-WANの見直しに役立つ複数の高度な機能を備えることで、お客様に以下のようなメリットを提供します。 起動時間の高速化を伴うネットワーク導入の迅速化 より堅牢な一連の導入シナリオと静音運用 卓越したパフォーマンスを最適化された消費電力で実現(「徹底した環境への取り組み」という当社の理念に沿って実現) ネットワークを次のレベルへと引き上げる包括的な組み込みセキュリティにより、機密データとアプリケーションを保護 個々のお客様のニーズに合わせたソリューションの提供を促進する、多様なプラットフォームオプション ブランチネットワーキングは長らく複雑さという問題を抱えていました。しかし、無線および有線、WANのすべてのAIネイティブネットワーキングスタックを、管理しやすい単一のプラットフォームにまとめることができるとしたらどうでしょうか? これこそが、SSR400とジュニパーの「ブランチインアボックス」(Branch-in-a-box)を背後から推し進めたインスピレーションです。このすべてを兼ね備えたソリューションは、リモートの従業員、仮設店舗、モバイルビジネスなどに最適です。 SSR400は単なるルーターではなく、現代のSD-WANの基盤となる存在です。この製品には、当社の革新的なセッションスマートルーティングテクノロジーが搭載されており、従来のトンネルベースのアーキテクチャではなく、トンネルフリーのアプリケーション認識型ネットワークを提供します。これにより、卓越したアプリケーションパフォーマンス、高性能のセキュリティ、ビジネスと同等の俊敏性を備えたネットワークファブリックを実現します。静的なIPsecトンネルや扱いにくい設定に苦労する日々は終わりました。 SSR400をJuniper Mist™クラウドに接続すれば、もう悩むことはありません。Marvis® AI搭載のMistプラットフォームでは、SD-WANエッジから無線アクセスポイントまで、ブランチネットワーク全体を一元的に管理できます。受賞歴のあるAIネイティブネットワーキングプラットフォームであるMistは、長年の強化学習を活用して、事前対応のトラブルシューティング、根本的原因分析、自動化を実現し、手動での操作の必要性を大幅に低減します。また、Marvis® AIアシスタントがエンドツーエンドで問題を検知、理解、修正できるようになったため、ユーザーと運用担当者に優れたエクスペリエンスを提供します。 SSR400は、完全なSelf-Driving Networkという当社の取り組みを証明するものです。当社は、AIネイティブのインテリジェンスに自動化とクラウドによる管理というシンプルさを組み合わせることで、シンプルさ、パフォーマンス、確固たるセキュリティを提供する業界屈指の一元的なプラットフォームをお客様にお届けしています。SSR400を導入すると、チームは事後対応に追われる状態から戦略的イノベーションに取り組める状態にシフトすることが可能となり、真の自動運転ブランチネットワークの可能性を最大限に引き出すことができます。

人工知能(AI)と高性能コンピューティング(HPC)は機械学習、自然言語処理、生成AI、ロボティクス、自律システムの進歩によって、大きな成長を遂げつつあります。 これらのイノベーションのコアには、大規模分散学習モデルがあります。このモデルは、多くの場合、複数のGPUにわたる数十億、数兆ものパラメータで構成されます。トレーニングプロセス中、これらのノードは相当量のデータを交換し合い、バックエンドAIイーサネットファブリックを使用して同期します。しかし、パケットロスは、同期の質を大きく低下させ、その結果、再送信や通信の停滞を生じさせ、最終的には、遅延の増加、ジョブ完了時間(JCT)の長期化、高価なGPUリソースの非効率な使用につながります。 課題:AIデータセンターファブリックにおけるサイレントパケットドロップ JCTは重要なメトリックです。現在のAIワークロード、特に大規模トレーニングと推論作業は、クラスター間での厳密な同期に依存しています。パケットが1つ失われても、パフォーマンスが大きな影響を受け、運用コストが増加する可能性があります。 たとえば、トラフィックの混雑によりスイッチのバッファがオーバーフローすると、RoCE v2パケットがAIイーサネットまたはIPファブリックでドロップする可能性があります。このような失われたパケットは再送信が必要となるため、これにより遅延が発生し、トレーニングや推論のフローの中断の原因となります。 Explicit Congestion Notification(ECN)は、IPヘッダー内にビットをマークすることによって混雑を伝えますが、混雑によってどのパケットがドロップしたのかは分からないので、再送信する必要があります。 解決策:Drop Congestion Notification(DCN:ドロップ輻輳通知) この問題に対処するために、ジュニパーは、Drop Congestion Notification(DCN)を導入しました。これは、Tomahawk 5チップベースのQFX5240-ODおよびQFX5240-QD—64 x 800GbEイーサネット、またはIPプラットフォーム向けの23.4x100d40 Junos OS(TM) Evolvedソフトウェアリリースで使用可能な新しい混雑管理機能です。 混雑が発生すると、スイッチはパケットペイロードを減らし、優先度の高いキューを介して受信ホストにその情報を転送します。ネットワークファブリック内の中継スイッチは、こうしたトリミングされてDCNでマークされた、ドロップしたパケットを認識し、そのパケットを優先度の高いキューに直接送ります。 結果として、エンドホストは、トリミングされたDCNパケットを処理し、混雑により明示的にドロップされたパケットを判断し、送信元からの失われたパケットの再送信を即座にリクエストしなければなりません。 しかし、トリミングされたパケットは送信先サーバーのメモリには送信されず、選択的再送信を必要とするパケットを正確に特定するために使用されます。これにより、デフォルトの再送信プロセスが長くなるのを回避し、結果として、ジョブ完了時のエンドツーエンドの遅延を改善することができます。 以下の図に、ECNしきい値を超え極度の混雑が発生した場合に最初のスイッチに入ったパケットがドロップされずにトリミングされ、送信先のGPUサーバーのNICカードに送信されるプロセスの簡素化されたトポロジーを示します。最初のスイッチがトリミングを行う一方で、中継スイッチもトリミングされたフレームを認識し、優先度の高いキューを介して送信インターフェイスにそのフレームをすぐに配置することができます。トリミングされたパケットが送信先のNICカードに到達すると、再送信パケットリクエストが送信元サーバーに送信されます。 図1:Drop Congestion Notification(DCN) QFX5240-ODスイッチとQFX5240-QDスイッチで、DCN関連パケットは、データパケットから分離された専用キューを通して処理されます。この分離によって、ユーザーは遅延と、DCNパケットに割り当てられた帯域幅をより効果的に管理できます。 設定例: カスタムL4 UDPポート番号をDCNプロトコル番号として設定します。スイッチはこの番号を使用して、DCNパケットを特定します。これはDCNを有効にするうえで必須の設定です。

HPE NetworkingのチーフAIオフィサーであるボブ・フライデーと私は、最近、Tech Field Dayのポッドキャストに参加しました。このポッドキャストの出発点となる前提は、「データセンターネットワークにはAIが必要」というテーマでした。私たちはこれに全面的に同意しています。ボブは、この10年の間、AIOps(IT運用のための人工知能)をネットワーキングに持ち込むパイオニアとして活動してきました。彼は、HPE Networkingの「Self-Driving Network™」への移行の道のりを説明することで議論をスタートさせました。このビジョンは、彼が最近発表した6回シリーズのブログで詳細に解説したものです。それから私たちは、特にデータセンターネットワークにとってのAIの意味について深堀りし、この分野で私たちが行ってきた取り組みの概要を説明しました。この2部構成のブログシリーズでは、以下について取り上げています。 解決すべき問題はあるか? 運用担当者は自社のネットワークに触れるのを恐れています。馬鹿らしく聞こえるでしょうが、ほとんどのネットワークエンジニアは、新サービスのプロビジョニングであれ、ファームウェアのアップグレードであれ、変更前も、変更中も、そして変更後も神経質になっています。そのプロセスは精神的にストレスがかかるものであり、運用担当者は、自分がネットワークに触れることでそれを壊してしまうのではないかと心配なのです。 データセンターネットワークにおけるこの流行にある基本的な問題は、複雑性です。理解しなければならないプロトコルの乱立、おそらくは数千におよぶ物理デバイスおよび論理デバイスの設定、管理すべき複数のインフラストラクチャベンダー。対応すべき課題は数多くあります。この複雑性に加え、運用担当者が対応する終わりのないデータの氾濫や、今日の市場に出回る多くの不適切なトラブルシューティングツールなどに、多くのデータセンターネットワークチームが圧倒されています。その結果、彼らはデータの海に溺れながら、インサイトに飢えているのです。 これこそまさに、賢いAIと機械学習アルゴリズムが役に立つ場面です。つまり、人間が取捨選択するにはデータが多すぎる一方、たいていの場合、データはしっかり構造化されています。 テクノロジーではなく、何を必要としているのかが問題 あまりに多くのテクノロジーの議論が間違った出発点、つまりはテクノロジー自体の話から始められています。私たちは、会社の上層部から次のようなことをよく言われます。「私たちは企業として、AIを使用する必要がある。そうでなければ出遅れてしまう」あるいは、ベンダーからこう言われるかもしれません。「御社のデータセンターネットワークではAIを使う必要があります」しかしこれらは、目的のない出発点です。あらゆるテクノロジーの議論は、自分たちの目的は何か、解決する必要がある問題は何か、というところから始めるべきです。 私たちの目標は常に明確でした。それは、「可能な限り最良のユーザーエクスペリエンスを提供すること」です。その「ユーザー」が、データセンターネットワークの運用担当者なのかデータセンターを利用するエンドユーザーなのか、また、ユーザーが自分が使用しているアプリケーションについて知っているか否かにかかわらずです。ここ10年にわたり、ジュニパーはAIを開発し、初めはWi-Fiに、次にキャンパスおよびブランチドメインの領域全体に広げし、驚くほど成功してきました。データセンターについては、私たちには後発者優位性があります。キャンパスでの導入から得られたあらゆるインサイトを手に入れられるからです。 データセンターネットワーク運用の課題 目標がユーザーエクスペリエンスの最適化なら、データセンター担当者が顧客と緊密に協力して解決する必要がある課題があります。私たちはそれらの課題を3つのカテゴリーに分けました。それらは、限られたインサイト、不十分なスピード、低い信頼性です。 インサイト:よくある状況として、企業のネットワークリードが、CRMアプリや、ERPシステムや、その他の重要なアプリがダウンすることに大きな不満を持つエグゼクティブから抗議の電話を受けることがあります。それは本当にネットワークの問題なのでしょうか? おそらくそうではありません。多くのネットワークチームは、ネットワーク上で実行中のアプリケーションに関するインサイトを十分持っていません。しかしはっきりさせましょう。データセンターで一番大切なことは、エンドユーザーが必要とするアプリケーションをホストし、提供することです。そのアプリケーションが、顧客にとって重要度の低いものであっても、ビジネスにとってミッションクリティカルなものであってもです。 スピード:発生しているもう1つの問題は、ITインフラストラクチャの管理の点で、スピードや俊敏性が不足していることです。何らかの予期していなかった需要の高まりのために素早く機能を追加しなければならないなど、緊急の新しいビジネス要件が発生し、企業が用意している標準的な変更管理プロセスやメンテナンス期間ではうまくいかなかった場合、そのプロセスの速さが十分でないか、あまりに柔軟性に欠けています。 信頼性:さらに、低い信頼性とダウンタイムは、現在進行中の懸念事項です。ほぼすべての企業にとって、たった1つの性急な変更や手動による設定ミスはネットワーク全体をダウンさせ、企業の評判や財務に多大な影響をもたらします。言うまでもなく、あなたのキャリアにとってもマイナスです。迅速で堅牢な自動リカバリやロールバック機能がない場合、サービスの復帰に数時間または数日におよぶ集中的な作業が必要になるかもしれません。あまりに多くのデータセンターネットワークの運用担当者が、自分が受け身の状態となっており、急場の処理や緊急事態に絶えず対処するばかりで、ビジネスをサポートするための事前対応型の戦略的なITイニシアティブに専念できていないことに気づきます。 万能の解決策としてむやみにAIに飛びつくのではなく、問題を徹底的に理解し、AIがそれらの問題の解決に役立つのかと自分に問いかけなければなりません。そしてその答えは、絶対的に「イエス」です。 AIは必要だが、それだけでは不十分である しかしAIは発生しているNetOpsの問題をすべて解決できるわけではありません。AIは必要だが、それだけでは不十分です。基本的に確率的なAIと、インテントベースネットワーク構築のような決定論的なアプローチの両方を使用するシステムが必要です。 設定の99%が正しければそれでOKでしょうか? いいえ、100%正しくなければなりません。それには、ルールベースの決定論的なソフトウェアが必要です。しかし、データセンターが予測不能な環境で稼働するDay 2では話が違ってきます。もし、無数の症状に基づいて、発生した問題の根本的原因を99%の正確さで伝えることができるシステムがあるなら、それはおそらく、今日そこにあるものより優れたソリューションです。そしてこれがAIのパワーです。大量のデータを絞り込み、相関関係を抽出します。これは人間には簡単にできません。 AIとインテントベースネットワーク構築という2つのテクノロジーを組み合わせれば、強力なネットワーク運用担当者エクスペリエンスと、エンドユーザー向けのアプリケーションエクスペリエンスを提供することができます。 このブログシリーズの2回目と最後のパートでは、AIOpsを使用して厄介なデータセンターネットワークの課題を解決する方法を深掘りする予定です。

今や、Self-Driving Network™は非現実的な話ではありません。当社のAIネイティブネットワーキングプラットフォームMist™におけるエージェント型AIの新たな機能強化により、これまでになく現実的なものとなっています。つまり、HPE Networkingが「アシスト型」ネットワーク運用から「自動運転」ネットワーク運用へのシフトをどのように迅速に進めているかということです。 他社はエージェント型AIの潜在能力について保証する言葉を並べていますが、当社は明確なビジョンと実証済みの結果とともに、そうした能力の提供をすでに行っています。 エージェント型AIの違いと強力な基盤が重要な理由 エージェント型AIが示すのは、さらに次の段階に進化した自動化です。さまざまなネットワークドメイン全体で、ほぼ人の介入なしで論理的判断、計画策定、コラボレーション、アクションを行うことができるエージェントを導入することで、ユーザーエクスペリエンスに悪影響を及ぼす前に事前対応で問題に対処します。 ただし、エージェント型AIが真の価値を発揮するためには、強力な基盤が必要です。HPE Networkingは、Marvis® AIエンジンとMarvis® AI Assistantとともに、10年以上にわたりこの基盤の開発を手がけてきました。Marvis AIエンジンは、ネットワーキングドメインや外部アプリケーションの全体で関連するテレメトリから継続的に学習を進めることで、AIの結果の有効性を改善し、問題解決を迅速に行い、クライアントからクラウドまでのユーザーエクスペリエンスを保証します。Marvis AI Assistantは、業界最先端の以下の機能を使用して、IT運用チームの運用方法やネットワークとのやり取りの方法を変革します。 Marvisの対話型インターフェイス:ユーザーがネットワークとやり取りする方法を変革 Marvis Minis:ユーザーエクスペリエンスを事前対応でシミュレーションし、問題が起こる前にその問題を検知 Marvis LEM(Large Experience Model):ネットワークのパフォーマンスに関する予測的なインサイトを提供 Marvis Actions:人間が関わる(HITL)信頼モデルに基づいて構築された自動修復を実現 中核的なこれらの要素を基盤にしているエージェント型AIは、自動運転ネットワーク実現の迅速化を促進します。本日は、このビジョンをより現実へと近づける、新たなエージェント型機能の強化について紹介します。 機能強化されたMarvis AI Assistant:すべてのドメインで機能するエージェント型AI 当社のMarvis AI Assistantの最新の機能強化として紹介するのは、キャンパス、ブランチ、データセンターの各環境にわたって真の価値を提供するエージェント型AIの機能です。当社の安全なAIネイティブネットワークは、すべての運用ドメインにわたってエージェント型NetOpsを拡張し、運用チームを統合してクライアントからクラウドまでの自動運用を簡素化します。

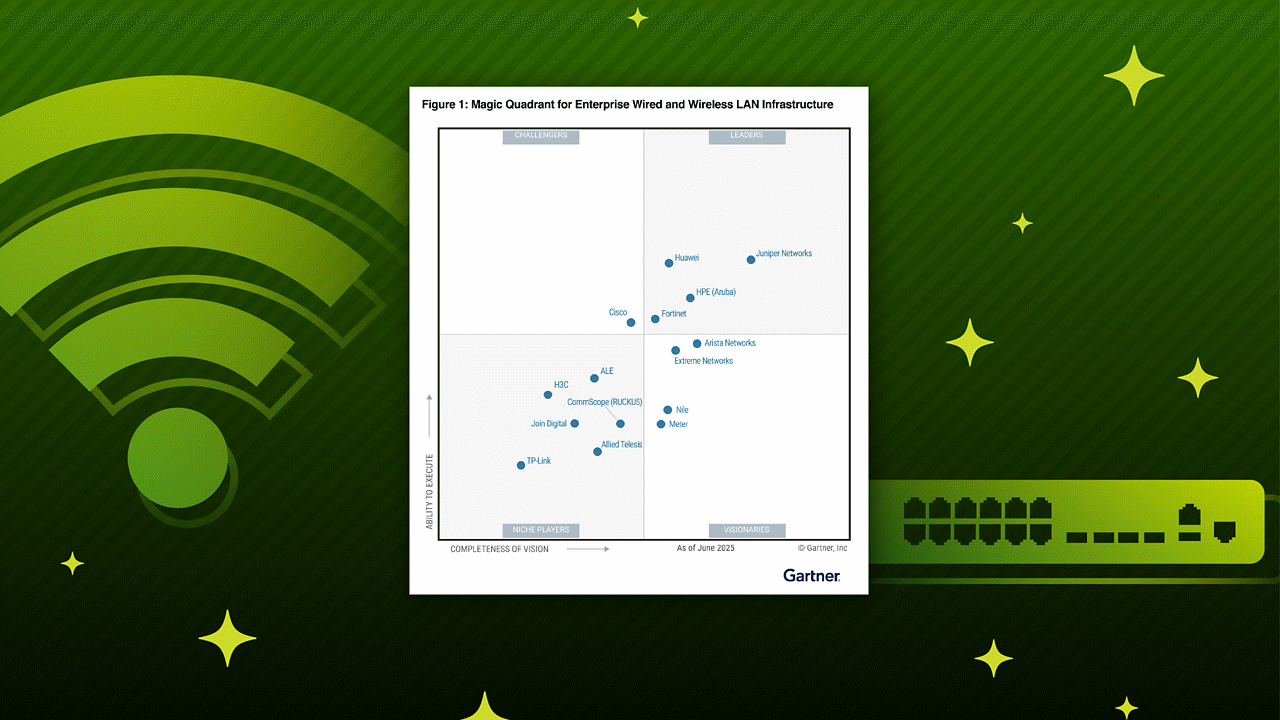

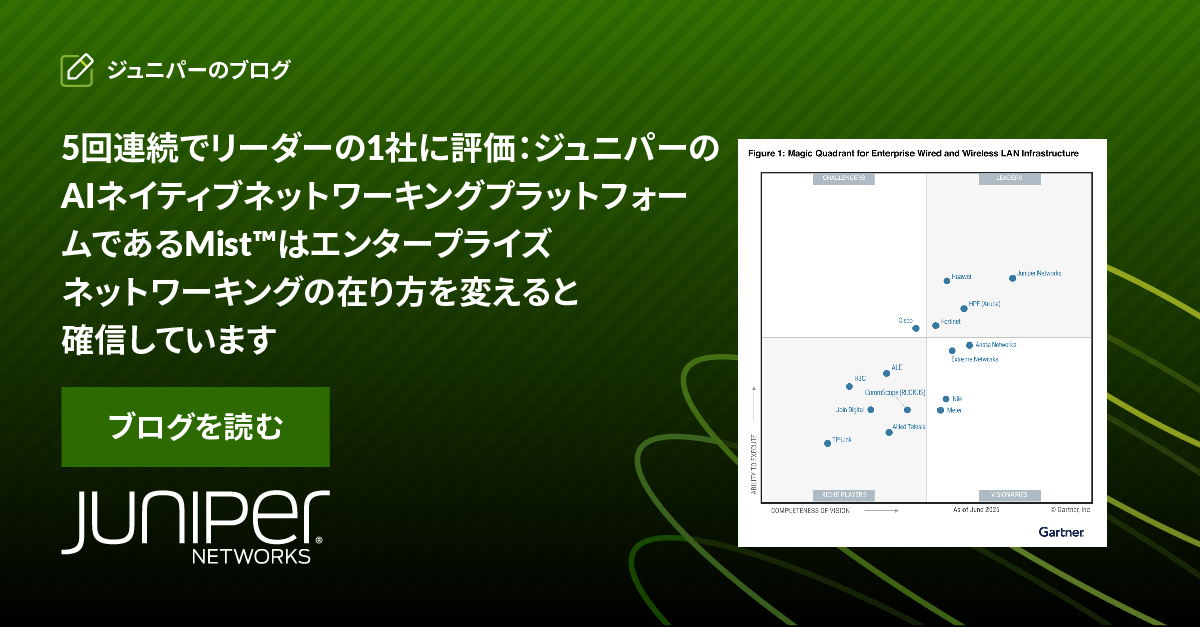

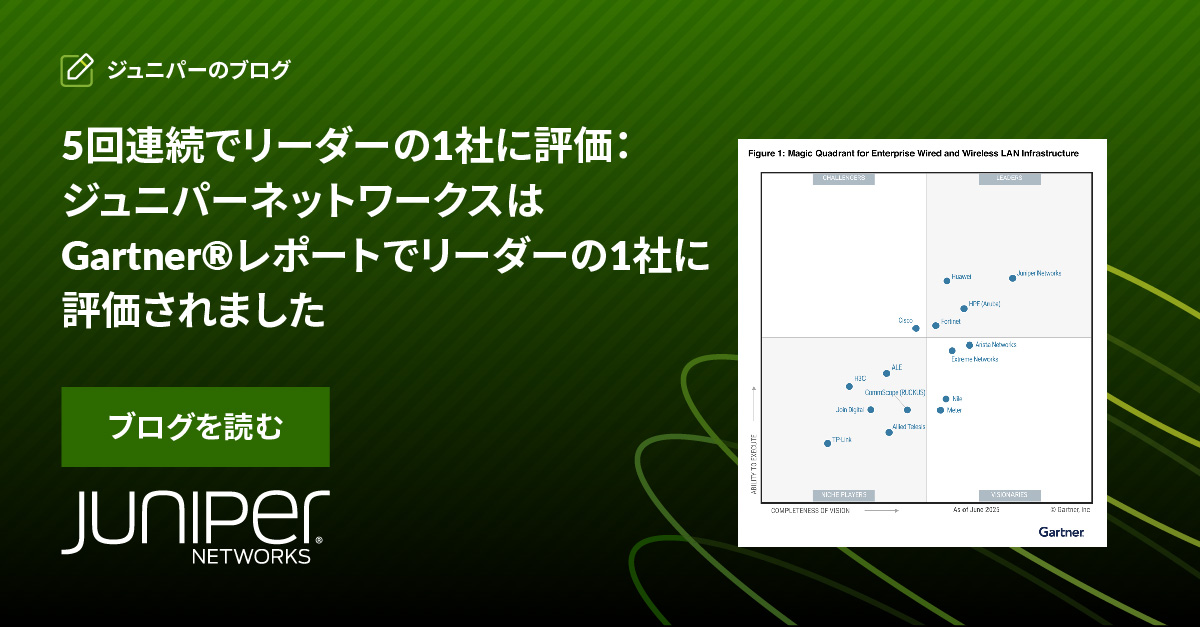

2025年度「Gartner® Magic Quadrant™ for Enterprise Wired and Wireless LAN Infrastructure」において、ジュニパーネットワークスが5回連続でリーダーの1社に位置づけられたことをお知らせいたします。 こうした評価は、ジュニパーのビジョン、実行力、そして最も重要な点として、ジュニパーのグローバルパートナーコミュニティの影響力を実証するものであると、私たちは考えています。 ただし、これはジュニパーがどのように評価されているかという話ではありません。今後向かうと思われる将来にも関わってきます。ジュニパーのMarvis® AI エンジンを活用したAIネイティブプラットフォームであるMistによってジュニパーが進めていることは、ネットワーキングの再構築だけではありません。ジュニパーのパートナーと共に、次の変革の波の先頭に立とうとしているのです。 Mist:AIネイティブで、業界をリードするために構築 MistはAIを後付けしたものではありません。AI向けに特別に構築されたプラットフォームです。業界初のAIネイティブネットワーキングプラットフォームであるMistは、キャンパスおよびブランチからデータセンター、セキュリティに至るネットワークの隅々にまで、自動化、自動修復、インテリジェンスをもたらします。単一のクラウド管理型アーキテクチャの下に有線、無線、WANを統合し、エンドツーエンドの可視化、自律型の自動化、組み込みのセキュリティを広範囲に提供します。Mistにより、以下のことを実現できます。 問題をリアルタイムに把握 問題が起こる前にその問題を予測 自動的に問題を修復(多くの場合誰にも気づかれないうちに) パートナーにとって意味するもの Mistにより、可能性が現実になります。 Mistは予測可能な収益性を確保できるように設計されています。最大90%の障害対応チケット数減少、85%のデリバリーコスト削減、9倍の導入迅速化により、パートナーはオーバーヘッドを削減でき、より価値の高いサービスに集中できます。 クラウドネイティブの設計とオープンAPIにより、事前対応の監視からフルスタックネットワーク管理まで、差別化を図れるマネージドサービスを容易に構築して拡張できます。Mistは、長期的かつ経常的な収益をもたらす出発点です。 その結果もたらされるのは、導入の迅速化と中断の減少であり、ユーザー、IT運用チーム、ビジネスの成果の向上です。 こうして、IT運用チームは障害対応に追われる状況から解放されてイノベーションを始められるようになり、パートナーは自信を持ってバリューチェーンを上へと上っていくことができます。 お客様にとっては、エクスペリエンスの向上を意味します。つまり、お客様は確実に機能するネットワークに常に接続できるようになり、そのことは信頼、ロイヤルティ、長期的な関係の構築につながります。 パートナーファーストの未来 ジュニパーは単にテクノロジーを構築しているだけではなく、変革も推進しています。そして、ジュニパーのパートナーはその中心に存在します。 何千もの環境にMistを実現してきました。ジュニパーは現在、新たなインセンティブ、柔軟な消費モデル、エキスパートによるサポートで、お客様の成功をさらに加速させています。 サービスを拡張しようとしている場合でも、新規市場に参入しようとしている場合でも、経常収益を拡大させようとしている場合でも、そのためのプラットフォームとプレイブックがMistによって提供されます。

本日、1つの評価を得たことをここにお知らせいたします。今回の評価は、私たちが現在どのように評価されているかだけでなく、私たちが進もうとしている将来の方向性に関しても多くのことを物語っていると考えます。 ジュニパーネットワークスは、2025年度「Gartner® Magic Quadrant™ for Enterprise Wired and Wireless LAN Infrastructure」において、5回連続してリーダーの1社に位置づけられました。 しかしこのことは、否定しようがないと私が確信しているあるトレンドの最新のデータポイントであるにすぎません。AIとネットワーキングの融合に伴い、AIネイティブのイノベーションと実現に対するジュニパーの貢献は引き続き、きわめて重要なものになっています。 Marvis® AI エンジンによるAIネイティブネットワーキングプラットフォームであるMist™は、企業、サービスプロバイダ、クラウドプロバイダの運用方法、拡張方法、イノベーションを進める方法を変革しつつあります。ジュニパーには、ユーザーと運用担当者に優れたエクスペリエンスを提供してきた長年にわたる実績があり、今後もそのペースを緩める予定はありません。 AIネイティブの時代が今ここに こうした変革の中心にあるのが、Marvis AI エンジンです。これは業界初で唯一の、仮想AIアシスタントが装備された組み込みAIのAIエンジンです。Marvisは質問に回答するだけでなく、完全なSelf-Driving Network運用を含め、事前対応の措置を講じます。アクセスポイントのソフトウェアやハードウェアの異常だけでなく、スイッチのポートの異常な動作などの問題を、ユーザーに気付かれる前に検出して解決します。RRM(無線リソース管理)を大幅に最適化し、ポリシーのアップデートを自動化します。また、あらゆるやり取りから継続的に学習することで、提供される結果も改善されていきます。 エージェント型AIの具現化であるデジタルエクスペリエンスツイン、Marvis Minisを利用すると、有線、無線、WANの全体にわたってユーザーとのやり取りをシミュレーションして、事前にネットワークのパフォーマンスを検証し、ユーザーに影響が及ぶ前に問題を予測できます。このMarvis Minisは、ZoomやMicrosoft® Teamsなどのきわめて重要なアプリケーションを最適化するため、継続的な学習を続けるAIエンジンにデータを供給します。 その結果、予測に基づくインサイト、エンドツーエンドのアシュアランス、常に一歩先を見据えるネットワークなどを利用できるようになります。特別な設定やセンサーや手作業による処理は不要です。これはIT部門にとって大きな戦力であり、事前対応のアシュアランス、予測に基づくインサイト、自己修復の自動化を大規模な形で提供できるようになります。 実際のお客様と実際の成果 これは単なる理論ではなく、現実の事例です。 ジョージワシントン大学:ほぼ7,000台のアクセスポイントと50台のアクセススイッチの導入を90日間で完了したジュニパーの自動化機能とオープンAPIにより、この地上で最も俊敏な高等教育機関ネットワークの1つへと強化されました。 ServiceNow:ServiceNowは、Marvis® AI

アプリケーション、サービス、コンテンツがこれまでにない量のネットワークトラフィックとデータを処理し続けている今日のデジタル環境では、中断のない情報のフローを確保することが企業にとって不可欠です。ネットワークはもはや企業の単なる設備ではなく、戦略的資産です。言い換えると、シームレスなネットワーク運用の確保がビジネスの成功にとって最も重要です。 ジュニパーネットワークスは、業界初のAIネイティブネットワーキングプラットフォームであるMist™ により、AIネイティブ革命をリードしています。これは、一貫して優れたユーザーエクスペリエンスを実現できるようにお客様をサポートするプラットフォームです。新しいMarvis® AIエンジン機能1の導入により、ジュニパーAIケアサービスは飛躍を遂げ、ネットワーク管理、セキュリティ、サポートを再定義する高度なサービスを提供しています。 ジュニパーAIケアサービスによりAIネイティブエクスペリエンスを強化 ジュニパーAIケアサービスは、お客様のビジネス成果に対するジュニパーの影響を広げることを意図した、ジュニパーのイノベーションとエクセレンスへの取り組みを示すものです。この独自のサービスポートフォリオは、ジュニパーの技術エキスパートのエクスペリエンスと知識をMarvis AIから得られるインサイトと組み合わせることで、お客様のネットワークライフサイクル全体にわたって最大限のROI(投資利益率)を達成できるように設計されています。 設計レビューやオンボーディングアシスタントからベストプラクティス、事前対応の健全性チェックや進行中の最適化ガイダンスまで、お客様のネットワークが最大の効率で運用されるようにジュニパーがサポートします。また、ジュニパーの無線アクセス、有線アクセス、SD-WANの各ポートフォリオに合わせて構成されたこのサービスにより、お客様のネットワークは継続的に最適化され、将来に対応できるネットワークになるように備えます。 Marvisでサービスエクスペリエンスを向上 ジュニパーAIケアサービスは、Marvis AIエンジンとMarvis® AI Assistantの強みを活用します。これらは連携して、自動化された事前対応のネットワーク管理とトラブルシューティングのAIネイティブネットワーキングによる基準を、新しいレベルの規模と精度で確立します。ITインフラストラクチャ全体から収集した接続前後のデータを活用することで、Marvis AIは、お客様が自社に合わせて設定したネットワークサービスとアプリケーションのSLE(サービスレベル期待値)に従い、サイトまたは企業レベルで可視性を向上します。 ダウンロード可能になったMarvis Minisでは、AIケアサービスを提供する技術リソースはまったく中断のないツールを利用できるようになり、トラブルシューティングの強化につなげています。ユーザーの接続をシミュレーションすることで、Marvis Minisは事前対応でネットワークとアプリケーションのエクスペリエンスを検証し、ユーザーに影響が及ぶ前に事前に問題の検知と解決をできるようにしています。Marvis Actionsは、実用的なインサイトの内容を深め、強調することで、比類のない運用効率とユーザーエクスペリエンスを実現します。加えて、新しいMarvis Clientは、これまで以上に個々のユーザーの問題の根本的原因を絞り込むのに役立ちます。AIケアサービスとMarvis AIは連携して、お客様の側でのダウンタイムの大幅な削減、エクスペリエンスの向上、ネットワークの信頼性向上を実現させています。 ジュニパーAIケアサービスのレベルの詳細 ジュニパーのAIケアサービスポートフォリオは、3つのレベルを通じて多様な企業のニーズに対応できるように構造化されています。 AIケアでは、AIを活用してチケットの解決を促進しているエンジニアから、24時間365日対応のテクニカルサポートが提供されます。選任のオンボーディングヘルプデスクや集中学習オンラインセミナーも利用できます。 AIアドバンスドケアでは、AIケアをベースに、単一の窓口(SPOC)の技術担当者から提供されるカスタマイズサービス、人間的なやり取りを行う運用アシスタンス、技術コンサルティング、設計レビュー、およびジュニパートレーニングに使用できるオールアクセスパス2枚が加わります。 AIアルティメットケアはジュニパーの最高レベルのサービスです。AIアドバンスドケアのすべてのメリットを含み、これに包括的なロールアウトアシスタンス、事前対応の健全性チェック、お客様の目標に合わせたカスタマーサクセスプラン達成を提唱するSPOCサービス担当者が加わります。 AIによる変革に向けた取り組み ジュニパーネットワークスのミッションは、すべての接続を大切にすることです。そのために、安全で優れた、持続可能なユーザーエクスペリエンスの促進に取り組んでいます。数千のお客様のネットワークから継続的に学習したジュニパーのAIツールは、ほぼリアルタイムで問題を特定するだけでなく、問題を予測し、自律的に問題を解決する可能性も秘めています。 先駆者としてジュニパーがお客様と進む道のりは、パートナーシップでもあり、インサイトでもあり、アクションでもあります。ネットワーク運用とサポートエクスペリエンスが単なる事後対応型ではなく、事前対応型で予測型かつアクション指向型であるような、AIによって変革された未来に向けて進むそれぞれの段階で、ジュニパーはお客様を常にサポートします。 次のステップに進むために、ジュニパーAIケアサービスの詳細をぜひご確認ください。 —