AI 모델을 학습시키는 것은 특별한 도전 과제입니다. Llama 3.1이나 GPT 4.0과 같은 대규모 언어 모델(LLM)을 개발하려면 전 세계에서 소수의 대기업만 사용할 수 있는 막대한 예산과 리소스가 필요합니다. 이러한 LLM에는 수십억에서 수조 개의 파라미터. 가 있어 적정한 작업 완료 시간 내에 학습하려면 복잡한 데이터센터 패브릭 튜닝이 필요합니다. 예를 들어, GPT 4.0은 1조 7,600억 개의 파라미터를 사용합니다!

이러한 수치를 이해하기 위해 각 파라미터를 카드 1장이라고 가정해 보세요. 52장으로 이루어진 카드 한 덱의 두께는 약 0.75인치입니다. 백만 장의 카드를 쌓으면 엠파이어 스테이트 빌딩보다 높고, 10억 장의 카드를 쌓으면 지구 열권 높이인 228마일, 1조 장의 카드를 쌓으면 달까지의 거리와 비슷한 227,000마일이 넘습니다.

AI 투자 성과를 최적화하는 방법

대부분의 기업의 경우 AI에 투자하려면 새로운 접근 방식이 필요합니다. 자체 데이터를 이용해 이러한 기본 LLM을 개선하여 특정 비즈니스 문제를 해결하거나 더 심층적인 고객 참여를 제공하도록 하는 것이죠. 그러나 AI 도입이 전면화되면서 기업들은 데이터 프라이버시 강화와 서비스 차별화를 위해 AI 투자를 최적화할 새로운 방법을 원하고 있습니다.

대부분의 경우, 이는 온프레미스에 있는 AI 워크로드 중 일부를 프라이빗 데이터센터로 이동하는 것을 의미합니다. 현재 진행 중인 ‘퍼블릭 클라우드 vs 프라이빗 클라우드’ 데이터센터 논쟁은 AI 데이터센터에도 적용됩니다. 상당수의 기업은 AI 인프라 구축이라는 새로운 도전을 두려워합니다. 도전은 분명 존재하지만 극복할 수 없는 것은 아닙니다. 기존 데이터센터 지식을 적용할 수 있죠. 약간의 도움만 있으면 됩니다. 주니퍼가 안내해 드리겠습니다.

이 블로그 시리즈에서는 AI에 투자하는 기업이 고려해야 할 다양한 고려 사항과 주니퍼가 AI 데이터센터의 ABC: 애플리케이션(Applications), 빌드(Build) vs 구매(Buy) 및 비용(Cost)이라고 부르는 접근 방식에 따라 어떻게 다른 접근 방식이 추진되는지 살펴봅니다.

하지만 먼저 AI 인프라가 왜 그렇게 전문화되어야 하는지 살펴봅시다.

LLM과 신경망의 이해

인프라 옵션을 더 잘 이해하려면 AI 아키텍처의 기본 사항과 AI 개발, 제공, 학습, 추론의 기본 범주를 이해하는 것이 도움이 됩니다.

추론 서버는 인터넷에 연결된 프론트엔드 데이터센터에 호스팅되며, 여기서 사용자와 디바이스는 완전히 학습된 AI 애플리케이션(예: Llama 3)을 쿼리할 수 있습니다. TCP를 사용하여 쿼리와 트래픽 패턴을 추론하면 다른 클라우드 호스팅 워크로드의 쿼리와 트래픽 패턴이 반영됩니다. 실시간으로 수행되는 추론 서버는 일반적인 컴퓨터 처리 장치(CPU) 또는 학습에 사용되는 것과 동일한 그래픽 처리 장치(GPU)를 사용하여 가장 빠른 응답과 가장 낮은 지연 시간(일반적으로 첫 토큰까지의 시간 및 증분 토큰까지의 시간과 같은 메트릭을 통해 측정)을 제공할 수 있습니다. 기본적으로 이는 LLM이 쿼리에 얼마나 빠르게 응답할 수 있는지를 나타내며, 규모에 따라 일관된 성능을 보장하기 위해 상당한 투자와 전문 지식이 필요할 수 있습니다.

한편으로는 학습에는 특별한 데이터센터 아키텍처가 필요한 고유한 프로세싱 과제가 있습니다. 학습은 LLM과 학습 데이터 세트가 ‘로그'(rogue) 인터넷으로부터 격리된 백엔드 데이터센터에서 수행됩니다. 이러한 데이터센터는 400Gbps 및 800Gbps 네트워킹 상호 연결을 사용하는 특수 레일 최적화 패브릭을 갖춘 고용량, 고성능 GPU 컴퓨팅 및 스토리지 플랫폼으로 설계됩니다. 대규모 ‘엘리펀트’ 플로우와 광범위한 GPU 간 통신으로 인해 이러한 네트워크는 완료하는 데 수개월이 걸릴 수 있는 지속적인 학습 주기의 용량, 트래픽 패턴, 트래픽 관리 요구를 처리할 수 있도록 최적화되어야 합니다.

학습을 완료하는 데 걸리는 시간은 LLM의 복잡성, LLM을 학습하는 신경망 내의 레이어, 정확도를 높이기 위해 조정해야 하는 파라미터 수, 데이터센터 인프라의 설계에 따라 달라집니다. 그렇다면 신경망이란 무엇이며 LLM 결과를 구체화하는 파라미터는 무엇일까요?

신경망(Neural Network) 101

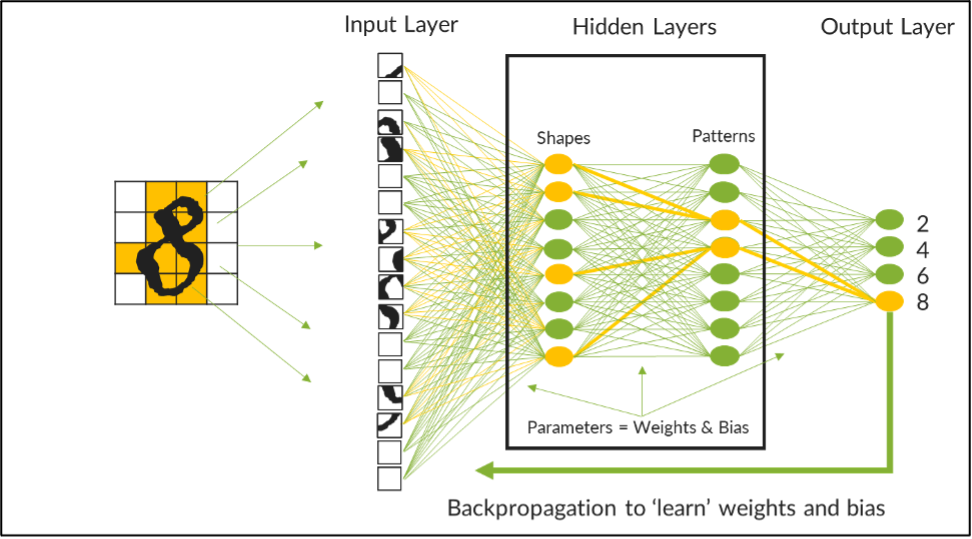

신경망은 인간 두뇌의 계산 모델을 모방하도록 설계된 컴퓨팅 아키텍처입니다. 데이터를 수집하는 입력 레이어, 결과를 표시하는 출력 레이어, 원시 데이터 입력을 사용 가능한 정보로 처리하는 중간에 숨겨진 레이어가 있는 일련의 점진적 기능 레이어로 구현됩니다. 한 레이어의 출력은 다른 레이어의 입력이 되므로 결과가 렌더링될 때까지 각 레이어의 신경 노드 또는 수학 함수 집합에서 쿼리를 체계적으로 분리, 분석, 처리할 수 있습니다.

예를 들어 아래 이미지는 손으로 쓴 처음 네 개의 짝수 숫자를 인식하도록 신경망에서 학습하는 LLM을 나타냅니다. 이 신경망에는 두 개의 숨겨진 레이어가 있는데, 하나는 모양을 처리하는 레이어이고 다른 하나는 패턴을 인식하는 레이어입니다. 손으로 쓴 숫자의 데이터 세트는 작은 블록으로 잘게 쪼개져 모델에 입력되며, 첫 번째 레이어에서 곡선과 선이 기능적으로 처리된 후 두 번째 레이어로 전송되어 분석 대상 숫자를 나타낼 수 있는 데이터의 패턴을 식별합니다.

최적의 LLM 정확도를 위한 파라미터 조정

최적의 LLM 정확도를 위한 파라미터 조정

각 레이어 내의 신경 노드에는 AI 과학자가 각 연결에 가중치를 적용할 수 있는 신경망 연결 메시가 있습니다. 각 가중치는 주어진 연결에 대한 연결의 강도를 나타내는 숫자 값입니다. 예를 들어 데이터의 위쪽 사분면에 있는 곡선은 2 또는 8에 더 높은 가중치를 부여하고 같은 사분면에 있는 선은 같은 값에 더 낮은 가중치를 부여합니다. 패턴을 볼 때 수직선과 직선의 집합은 4에 강한 연결과 더 높은 가중치를 가지며, 선과 곡선의 집합은 2, 6 또는 8에 강한 연결과 가중치를 가질 수 있습니다.

학습을 시작할 때 모델의 결과는 매우 부정확할 수 있습니다. 그러나 학습을 실행할 때마다 이러한 신경 연결의 가중치를 조정하거나 ‘튜닝’하여 정확도를 점진적으로 높일 수 있습니다. 강한 연결과 약한 연결의 구분을 강화하기 위해 각 연결에 숫자 편향이 적용되어 강한 연결은 증폭하고 약한 연결은 억제합니다. 가중치와 편향은 함께 LLM의 정확도를 개선하기 위해 조정해야 하는 파라미터를 나타냅니다.

이 간단한 예시에서는 모델이 각 숫자를 높은 정확도로 식별하기 위해 반복적으로 조정해야 하는 파라미터가 242개에 달합니다. 수십억 또는 수조 개의 파라미터를 처리할 때는 역전파 알고리즘을 사용하여 프로세스를 자동화합니다. 하지만 학습은 매우 긴 프로세스이며 데이터센터의 기본 물리 네트워크에서 발생할 수 있는 처리 지연 시간으로 인해 지연되거나 중단될 수 있습니다. 데이터센터 네트워크가 제대로 설계되지 않은 경우에는 테일 레이턴시(Tail Latency)라고 하는 이 현상으로 인해 학습 프로세스에 상당한 시간과 비용이 추가될 수 있습니다.

다음 블로그에서는 기업이 이러한 기본 LLM을 활용하여 프라이빗 데이터센터에서 제공되는 자체 맞춤형 AI 애플리케이션을 구축하는 방법에 대해 설명합니다.

다른 조직에서는 이러한 문제를 해결하기 위해 어떻게 인프라를 구축하고 있는지 알고 싶으신가요? 온라인 이벤트 Seize the AI Moment에서 AMD, Intel, Meta, PayPal 등의 인사이트를 확인해 보실 수 있습니다.