HPE NetworkingのチーフAIオフィサーであるボブ・フライデーと私は、最近、Tech Field Dayのポッドキャストに参加しました。このポッドキャストの出発点となる前提は、「データセンターネットワークにはAIが必要」というテーマでした。私たちはこれに完全に同意しています。この2部構成のブログシリーズのパート1では、AIを使用するか否か、またAIをどのような方法で使用するかに関する議論は、特定の目標と、現在直面していて解決の必要がある問題に基づいて行われる必要があることを強調しました。データセンターネットワークの運用担当者が抱えている課題を検証した後であれば、AIが実際に役に立つことは明らかです。どのように役に立つのかについて、以下で説明します。

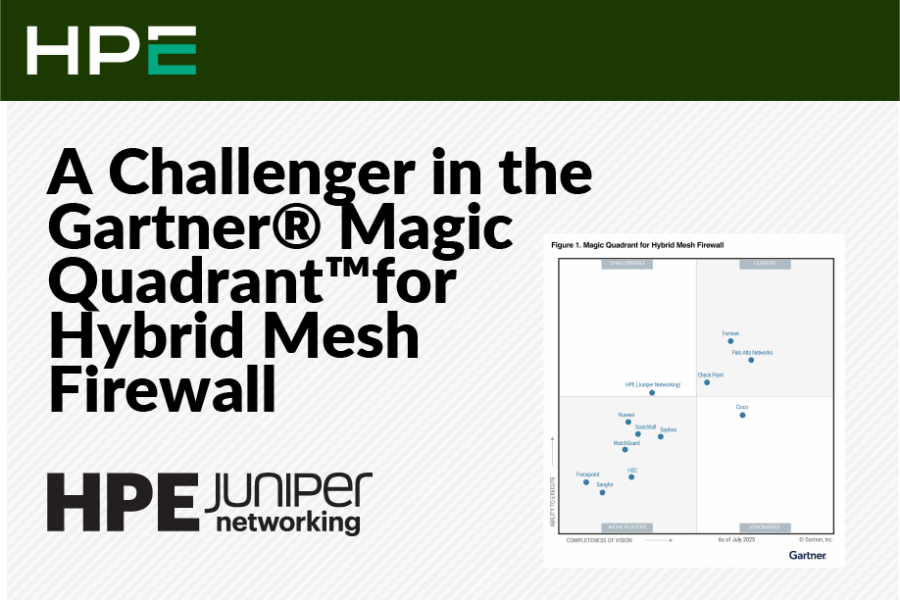

AIネイティブのイノベーションがデータセンターのリーダーシップを拡張

AIの性能の改善は急速に進んでいるため、Day 0の設計、Day 1の導入からDay 2の継続的運用に至るデータセンターのライフサイクル全体で、AIが占める役割は疑いなくますます大きくなっています。私たちは先日、データセンターネットワークのための新しいAIOps機能をいくつか発表しました。

- 予測メンテナンスにより、ネットワーク運用担当者は、将来発生するかもしれない問題を特定し、実際に発生する前にその問題を解決できます。

- システム正常性プロセッサーとメモリの使用率や温度などの分析データに基づいて、スイッチで障害が発生する時期を予測します。

- 容量リンク使用率やトラフィックの増加などのデータに基づいて、ファブリックの拡張が必要になる時期を予測します。

- 光インターフェイスTx/Rxのスループット、電力、電圧などに基づいて、光トランシーバで障害が発生する時期を予測します。光インターフェイスのグレー障害は常に問題であり、完全な障害よりも深刻な(検知しにくい)場合があります。

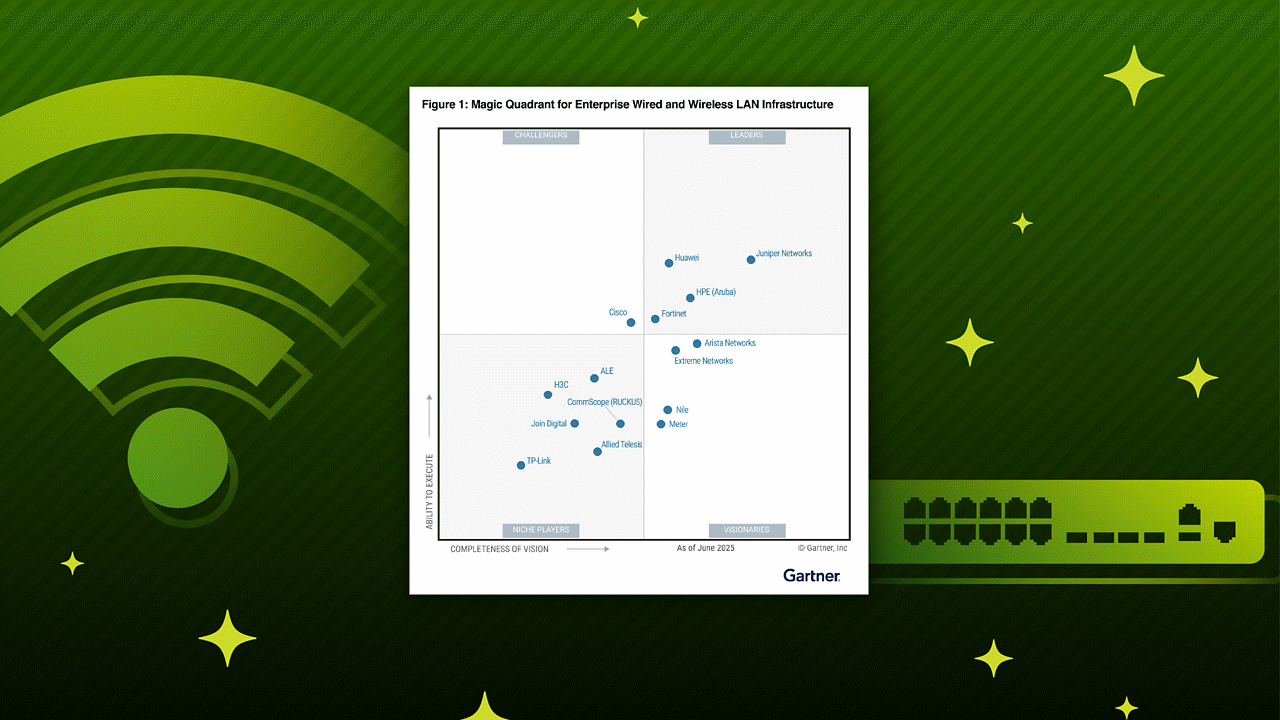

こうした例の多くで、最初に提供された時点では、この機能は動的で応答的な形でAIを使用していません。当初は多くの場合、システムはアラームをトリガーする静的なしきい値を設定しています。しかし、良いブドウが良いワインを作るように、優れたAIを作るのは優れたデータです。データの蓄積には相応の時間がかかり、ジュニパーが競合他社と比べて優位性を持っている理由はそこにあります。ジュニパーはMist®プラットフォームで10年以上かけてAIOpsを実施してきました。優れたAIはデータを蓄積し、学習とトレーニングを繰り返し、適応するための時間を必要とします。このようにして、ユーザーエクスペリエンスの最適化という目標に到達します。データセンターでは、AIOpsはいまだに成長初期の段階ですが、その改善はきわめて迅速に進んでいます。

- サービスレベル期待値が設定されていると、広範なネットワークパラメーターの合算処理、総括的な健全性メトリックの算出、特定の時期のこれらのメトリックに影響を与える問題の分析を行う必要が出てきます。その結果、お客様は、ネットワークがアプリケーションオーナーやエンドユーザーのニーズを満たしているかどうかを明確に把握できるようになります。

- ドキュメントのクエリは、仮想ネットワークアシスタントの典型的な基本ユースケースです。多くのインフラストラクチャベンダーがまずこれから始めて、LLMを製品ドキュメントに関連付けて検索の精度を高めようとします。LLMを実際のエンタープライズソフトウェアアプリケーションに関連付けたり、当社の事例であれば、ネットワーク管理および自動化ツールに関連付けたり、アクセス可能な大量のデータに関連付けるなど、より高度な使い方をするようになります。ネットワーク運用担当者は、現在の方法よりも優れた、新しい別の方法(自然言語を介す方法)でツールを操作できます。AIアシスタント「Marvis™」により、私たちはビジネスにおいて最高のサポートを提供できます。

- アプリケーションアシュアランスは欠かすことができません。アプリケーションをホストしてエンドユーザーに提供することが、データセンターのまさに核心だからです。当社のソリューションは、AIOpsとインテントベースネットワーク構築を結び付けます。トラフィックフローが正常な状態でない場合、異常検知アルゴリズムによって検知されます。特定の時刻にどのアプリケーションのフローがどのポートを経由して行われているかという決定論的な把握に、こうしたインテリジェンスが結び付けられ、ネットワーキングとアプリケーションのパフォーマンスがひとまとめにされます。

- そして、おそらくこれが最も重要な点ですが、データセンターにおけるAIOpsの最終的なカテゴリーは、単純に「実験」です。LLM(大規模言語モデル)は、ほとんど魔法のような驚くべきメカニズムです。このモデルを構築した人たちは、このモデルが動作する仕組みの背後にある直感能力のようなものを、必ずしも理解していないことを認めるでしょう。

エンタープライズビジネスの変革を広い意味で捉えると、すべての企業が基本のLLMを取り込み、これに調整を加えているといえます。企業は自分たちの手元にある企業データという宝の山をベクトル化し、RAG(検索拡張生成)を通じてAIモデルに取り込ませています。ソフトウェアを販売している企業はすべて、自社のソフトウェアをLLMや他のAIモデルに結び付けるという実験を進めているといえます。ネットワーキング業界寄りである当社は、MCP(Model Context Protocol)がエージェント型AIの主要なファシリテーターであると想定しています。エンタープライズソフトウェア用にMCPサーバーを構築していないのであれば、今すぐ構築してください。

今後数年間で進む相当数のAIイノベーションが、お客様主導になると考えられます。ベンダーがオープンシステムをお客様に提供することで、驚くような、想定外の結果がもたらされる可能性があります。企業の歴史全体を通じて、多くの業界がサプライヤではなくエンドユーザーによる革新的なイノベーションによって変革を遂げてきました。

刺激的な時代に生きる

私たちの多くは世の中に流布するAIに関する情報の山に埋もれており、その情報が飛び交うスピードに圧倒されています。最新情報を常に把握したいとは考えていますが、圧倒されたくないと思っています。とはいえ、AIはかつてないほど手に入れやすく身近なものとなっています。誰もがHugging Faceから無数に存在する利用可能なAIモデルを無料でダウンロードできます。初心者でも容易にMCPサーバーを構築して、多数のデータソースに接続できます。そして、何かの問題で行き詰ったら、Claudeにサポートをお願いできます。LLMは、まるで対話可能な実在の人物のように思われ始めています。ネットワークエンジニアにとっては、本当に刺激的な時代です。