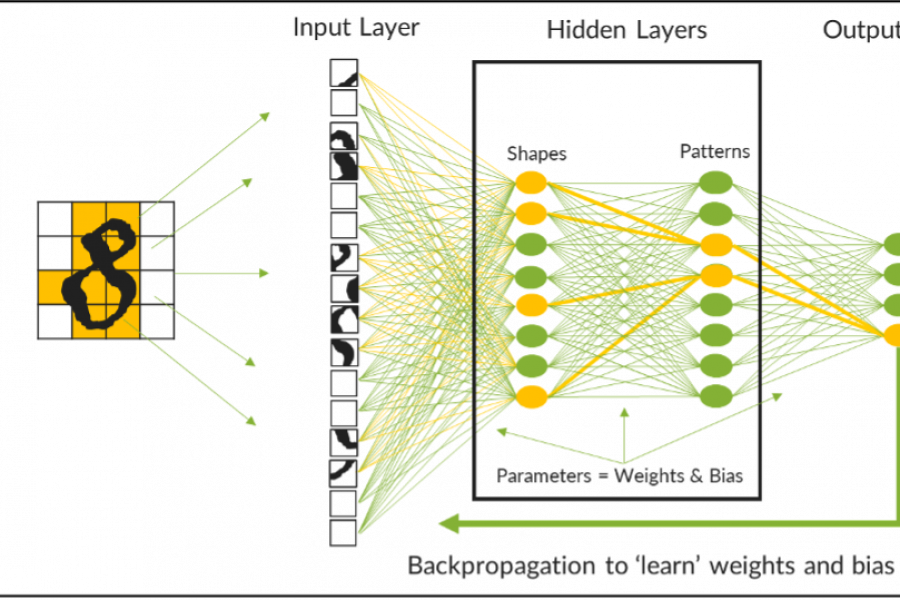

このブログシリーズの初回では、LLMのトレーニングにおける課題を取り上げました。前回は、AIに投資する企業のLLM消費モデルであるMaker(作成者)、Taker(使用者)、Shaper(形成者)、RAGを確認しました。今回は、AIアプリケーションの導入モデルと、各モデルのコストに関する検討事項について説明します。

AIの導入により、AIデータセンターが大きく成長し、投資が大幅に増加しています。以前はクラウドプロバイダがほぼ独占状態でしたが、現在は企業がプライベートデータセンターを利用して自社のAIデータセンターを拡張し、AIワークロードとアプリケーションの制御を自ら行うようになっています。

AIデータセンターへの投資を最大限に活用する

IDCによると、AIデータセンターのスイッチング機器への企業投資が、2027年までに10億米ドルに増加し、年平均成長率が158%になると予測されています。クラウドプロバイダのスイッチングも同期間で年平均成長率91.5%と顕著な増加が続くと見込まれますが、一部の企業は、ハイブリッドクラウド戦略を採用するために、トレーニングや推論のワークロードの一部をプライベートデータセンターへ移す予定です。

生成AIで意味のある結果を引き出すには、モデルで自社データを使用しなければならないとほとんどの企業が気づいています。AIによるデジタル変革は、従業員に業務でパブリックLLMを使用するよう指令を出すように簡単にはいかないのです。

構築と購入:どちらを選ぶか?

自社のプライベートデータセンターを構築する。パブリッククラウドプロバイダからAIサービスを購入する。両方を組み合わせたハイブリッドクラウドモデルを使用する。どれを選択しても結局は大きな問題が立ちはだかります。

- データの機密性:扱っている機密データや専有データローカルは、プライベートクラウドに保存する必要がある、もしくはデータの地理的境界を制限するデータ主権ルールの対象になっていませんか? テクノロジー業界や金融業界、政府機関、医療業界のユースケースでは、知的財産を保護するため、あるいは訴訟を避けるためにプライベートデータセンターが必要になる傾向があります。

- 専門知識:データサイエンスやネットワーキングに関する知識のある従業員はどの程度いますか? 適切な人材を確保している場合は、プライベートデータセンターの展開が強力な選択肢になります。しかし、そうでなければ、社内で専門知識を養うかアウトソーシングしなければなりません。

- 地理的要因:自社のデータセンターニーズをサポートできる十分なファシリティ(施設や設備)が、必要とされる場所にありますか? GPUあたり700W消費するため、大規模なトレーニングクラスターでは、既存のファシリティにコストのかかる電力のアップグレードが必要になることもあります。あるいは、電力を予算内に抑えるため、AIクラスターをさまざまな場所にあるデータセンターに分散することもできます。RAGなどの推論パフォーマンスにより、AIデータセンターがエッジの方へ移る可能性があります。そうなると、小さなAIクラスターが物理的にユーザーに近づきます。例えば、IoTアプリケーションが製造現場に展開されることになります。また、ハイブリットアーキテクチャでは、トレーニングや推論、RAGのためのAI機能を適切な場所に展開するために、データセンターを構築できる場所では構築し、構築できないが必要な場所では購入することができます。

- 市場投入期間:市場投入に対する圧力はありますか? 即時の投入を求められているなら、パブリッククラウドサービスです。市場投入期間が短縮され、プライベートデータセンターの導入を計画したりする貴重な時間を確保できます。AIによる変革はどこまで進んでいますか? まだ着手したばかりで、自社での効果を知るために実験を繰り返す必要がある状態ですか? その場合も、パブリッククラウドがお勧めです。しかし、AIに熱心に取り組んでいて、ビジネスのさまざまな分野での使い方を計画している場合は、経済分析によると、一般にプライベートクラウドインフラストラクチャへの投資が推奨されます。

企業戦略:多くのクラウド変革プロジェクトがそうであるように、AIへの取り組みも部門レベルで始まることが多く、特定の顧客や運用上の課題の解決を目的に、独立したAIクラスターがさまざまな場所で作り出されています。企業が、AIインフラストラクチャの統合や共有を進める包括的な企業戦略を立てれば、AIの投資コストの償却効率も上がり、プライベートデータセンターのAI投資を既存の企業予算内に収めることができます。

当初、パブリッククラウドはAIテクノロジーのイノベーターや早期導入者にとって唯一の選択肢でした。依然として大半のAI戦略でパブリッククラウドが重要ではありますが、データのセキュリティやコストに対する懸念から、プライベートデータセンターやハイブリッドクラウドアーキテクチャが主流になりつつあります。ジュニパーのオンラインイベント「Seize the AI Moment(AIでチャンスをつかむ)」では、お客様、パートナー、業界の専門家が独自のハイブリッドクラウドのユースケースや戦略について議論しています。その中では、金融機関のデータセキュリティ問題や、コストとパートナーのバランスを取るためのハイブリッドクラウドを使用した戦略などが話題になりました。

コスト:費用のかかるAIの世界でROIを最大化

どの導入モデルでも、AIの展開に費用がかかることに変わりはありません。AIのコストは、予算、専門知識、時間の観点から計算されますが、いずれの要素もリソースに限りがあります。専門知識と時間のコストは企業によって異なりますが、AIへのハードダラー投資は市場主導で変化し、割り当てられた予算のみが障壁になります。

GPUサーバー1台あたりのコストは、およそ40万ドル。そのため、小規模AIデータセンターのインフラストラクチャコストだけでも数百万ドルになる可能性があります。しかし、希望の光も見えてきました。PyTorch 2.0のようなAIフレームワークが、NVIDIA製チップセットとの緊密な統合や依存を解消したのです。これにより、IntelやAMDなどの競合GPU製品にも扉が開かれ、市場力学が崩壊し、コストの正常化に向かっています。

現状レベルでは、パブリッククラウドプロバイダからAIサービスを購入したほうが、プライベートAIデータセンターを構築するよりコスト効率に優れていると容易に予測できます。一方、ACG Researchの最新の総所有コスト(TCO)分析からは異なる結果が出ています。プライベートAIデータセンターとパブリッククラウドでホストされる同等のAIサービスの3年間のTCOを比較したところ、プライベートデータセンターモデルの方がTCOを46%節約できることがわかりました。この主な原因は、パブリッククラウドサービスに関連する高額な定期コストです。

ACGのレポートでは、AIデータセンターの構築コストについても、InfiniBandとイーサネットのネットワーキングコストを比較して詳しく分析しています。その結果、ジュニパーのイーサネット(RoCE v2)とJuniper Apstraを導入すると、InfiniBandネットワークと比較して、3年間でOpEx(運用費)の56%削減、CapEx(設備投資費)の55%削減、TCOの55%削減を実現できることがわかりました。

最終的にいえるのは、AIデータセンターの構築はコスト効率に優れた選択肢であり、パブリッククラウドのコスト面のメリットを相殺する効果があること、また、イーサネットベースのAIファブリックを構築すると、今ある社内の知識を活用して迅速に導入できるため、コストをさらに削減できるということです。

プライベートエンタープライズとハイブリットAIの導入を簡略化

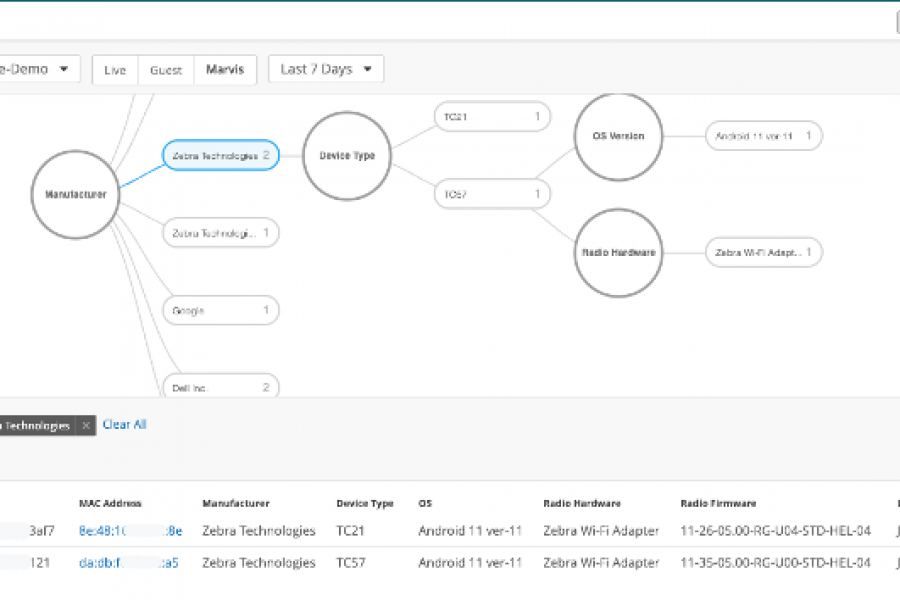

プライベートまたハイブリッドクラウドモデルに投資する際、大きな障壁となるのが、アプリケーションニーズ、導入モデル、コストです。とはいえ、企業は社内だけで対応する必要はありません。AIはほとんどの企業にとってなじみがなく、AIインフラストラクチャは複雑な課題をもたらしますが、不可解な魔術ではありません。現在備えているデータセンターネットワーキングの知識の大部分を活用できます。ジュニパーは、イノベーションを促進するためにAIテクノロジーに投資している一方で、AI導入の簡略化にも取り組んでいます。ジュニパーのOps4AIラボは、GPUコンピューティングのマルチベンダーアーキテクチャや、高度なストレージプラットホームのほか、QFXシリーズスイッチや、PTXシリーズのルーター、Juniper Apstraネットワーク自動化などのレール向けに最適化されたジュニパーのイーサネットファブリックを使用し、企業が導入前にカスタムAIクラスターの設計を確認できるようにしています。AIイノベーションラボでは、オープンソースとお客様の自社モデル(BYOM)の両方を使い、お客様の不安を払拭するサポートをします。

ジュニパーのOps4AIラボはお客様とともに

ジュニパーのOps4AIラボは、事前検証済みのマルチベンダーAIデータセンターのジュニパー検証済み設計(JVD)パイプラインを推進するエンジンの役割も果たします。企業は、JVDを通じ、サポートされているコンピューティングやストレージのインフラストラクチャとジュニパーの高度なAIデータセンター設計と組み合わせ、複雑になりがちな設計や導入において憶測による対応をなくし、全体を簡略化できます。

また、Juniper Apstraのネットワーク自動化を使用することで、独自の展開に使用する設計図を作成したり、ジュニパーのTerraformプロバイダを使用して、GitLabがホストするバックエンドコンピューティングや、バックエンドストレージ、フロントエンドマネジメント用のAI設計図をダウンロードできます。

ジュニパーのOps4AIラボ、お客様のAIユースケース、NVIDIAや、AMD、WEKA、Inteなどを含むAIパートナーのエコシステムについて詳しくは、ジュニパーのAIオンラインイベント「Seize the AI Moment(AIでチャンスをつかむ)」をご視聴いただくか、このリンクからAIデータセンターのページへアクセスしてください。