Em janeiro de 2024, a Juniper lançou a AI-Native Networking para utilizar os dados certos por meio da infraestrutura certa e fornecer as respostas certas para experiências ideais de usuários e operadores. Com base na IA para operações de rede simplificadas (AI for Networking) e malhas Ethernet otimizadas para IA para obter melhor carga de trabalho de IA e desempenho de GPU (rede para IA), a Juniper está cumprindo nosso compromisso com o cliente de rede que prioriza a experiência.

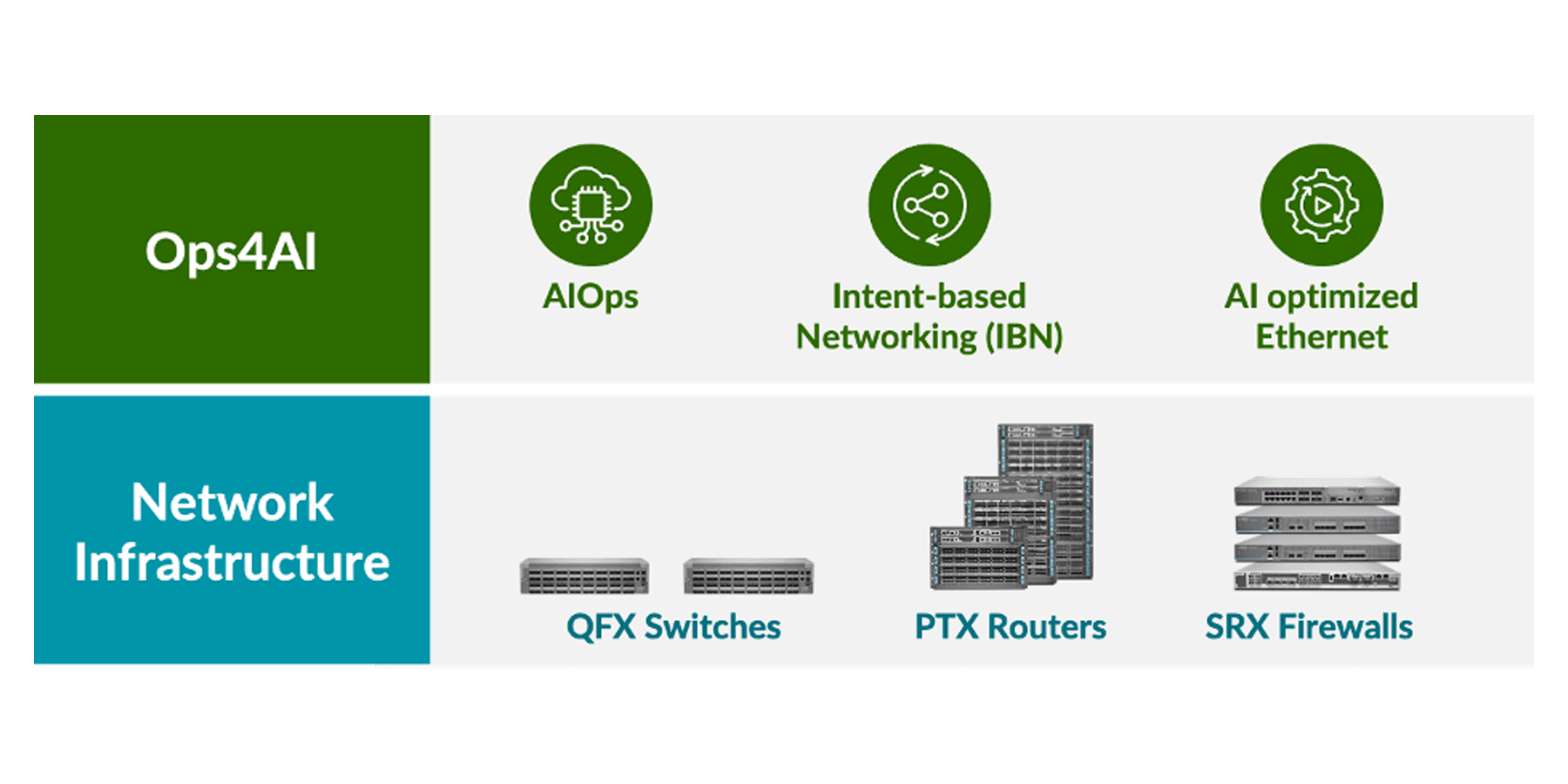

Com base em nosso rico histórico de fornecimento de infraestrutura de rede de data center seguro de alto desempenho, que consiste em switches QFX, roteadores PTX e firewalls SRX, a Juniper tem o orgulho de anunciar uma extensão de nossa arquitetura AI-Native Networking, oferecendo aos clientes operações completas de vários fornecedores para data centers com IA. Nossa nova solução, Ops4AI, oferece melhorias impactantes que agregarão ainda mais valor aos clientes. O Ops4AI inclui uma combinação exclusiva dos seguintes componentes da Juniper Networks:

- AIOps no data center baseado no Marvis Virtual Network Assistant

- Automação baseada em intenção por meio do gerenciamento de malha de data center de vários fornecedores Juniper Apstra

- Recursos Ethernet otimizados para IA, incluindo RoCEv2 para IPv4/v6, gerenciamento de congestionamento, balanceamento de carga eficiente e telemetria

Com tudo isso, o Ops4AI permite uma rápida aceleração do time-to-value de data centers com IA de alto desempenho, ao mesmo tempo que reduz os custos operacionais e simplifica os processos. E agora a solução está ficando ainda melhor com a adição de vários novos aprimoramentos: Um novo Juniper Ops4AI Lab multifornecedor aberto aos clientes para testarem modelos e cargas de trabalho de IA privadas e de código aberto; Juniper Validated Designs, que garante rede para configurações de IA usando Juniper, Nvidia, Broadcom, Intel, Weka e outros parceiros; e melhorias no software Junos e no Apstra para redes de data center otimizadas para IA – o foco principal deste blog.

Os novos aprimoramentos do software Junos® e Juniper Apstra incluem:

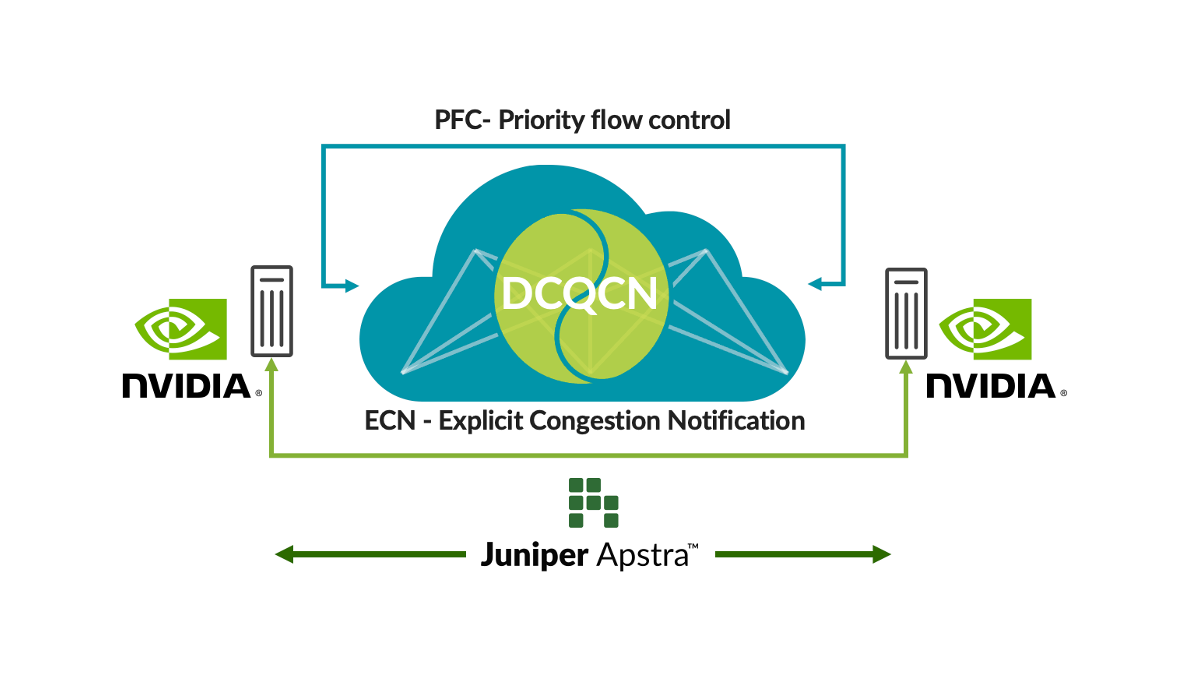

Ajuste automático da malha para IA

O Acesso Remoto à Memória Dinâmica (RDMA) das GPUs gera um tráfego de rede enorme nas redes de IA. Apesar das técnicas de prevenção de congestionamento, como balanceamento de carga, em alguns casos, ele é inevitável, como por exemplo, no tráfego de várias GPUs indo para uma única GPU no switch de último salto. Quando isso ocorre, os clientes usam técnicas de controle de congestionamento, como a Notificação Quantificada de Congestionamento do Data Center (DCQCN). O DCQCN usa recursos como Notificação de Congestionamento Explícito (ECN) e Controle de Fluxo Baseado em Prioridade (PFC) para calcular e definir configurações de parâmetros para obter o melhor desempenho para cada fila para cada porta em todos os switches. Configurá-los manualmente em milhares de filas em todos os switches é difícil e trabalhoso.

Para resolver esse problema, o Apstra coleta regularmente a telemetria de cada uma dessas filas para cada uma das portas. Essas informações de telemetria são usadas para calcular as configurações de parâmetros ECN e PFC ideais para cada fila de cada porta. Usando a automação de loop fechado, as configurações ideais são definidas em todos os switches da rede.

Esta solução fornece as configurações ideais de controle de congestionamento, simplificando consideravelmente as operações e proporcionando latência e tempos de conclusão de trabalho (JCTs) mais baixos. Nossos clientes estão investindo tão massivamente em infraestrutura de IA que disponibilizamos esses recursos agora no Juniper Apstra sem custo adicional. Assista a uma demonstração do último Cloud Field Day para ver como eles funcionam de perto. Também enviamos este aplicativo para o GitHub.

Figura 1: Ajuste automático da malha para IA

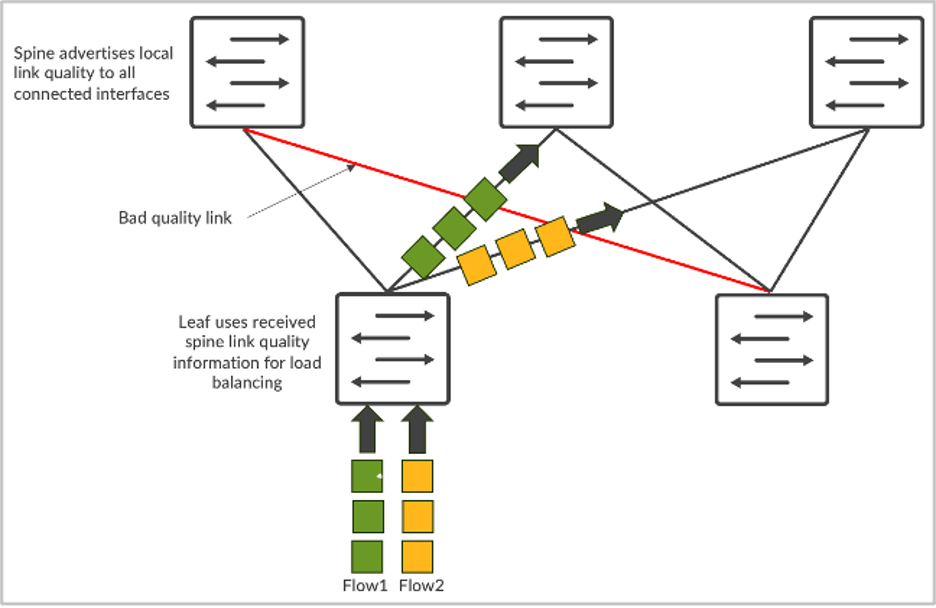

Balanceamento de carga global

O tráfego da rede de IA tem características únicas. Ele é impulsionado principalmente pelo tráfego de RDMA de GPUs, o que resulta em alta largura de banda e menos fluxos, porém maiores (geralmente chamados de fluxos elefantes). Como resultado, o balanceamento de carga estático baseado em hash de 5 tuplas não funciona bem. Vários fluxos elefantes são mapeados para o mesmo link e causam congestionamento. Isso resulta em JCTs mais lentos, o que é devastador para grandes investimentos de GPU.

Para resolver o problema, o balanceamento de carga dinâmico (DLB) está disponível. O DLB leva em consideração o estado do uplink no switch local.

Comparado ao balanceamento de carga estático tradicional, o DLB melhora consideravelmente a utilização da largura de banda da malha. Mas uma das limitações do DLB é que ele apenas rastreia a qualidade dos links locais, em vez de compreender toda a qualidade do caminho, desde o nó de entrada até o nó de saída. Digamos que temos topologia CLOS, e o servidor 1 e o servidor 2 estão tentando enviar dados chamados fluxo-1 e fluxo-2, respectivamente. No caso do DLB, o leaf-1 conhece apenas a utilização dos links locais e toma decisões com base exclusivamente na tabela de qualidade do switch local, onde os links locais podem estar em perfeito estado. Mas, se você usar o GLB, poderá entender toda a qualidade do caminho onde os problemas de congestionamento estão presentes no nível do spine-leaf.

Figura 2: Balanceamento de carga dos fluxos

É semelhante ao Google Maps, onde a rota selecionada é baseada em uma visualização de ponta a ponta.

Esse recurso seleciona o caminho de rede ideal e oferece menor latência, melhor utilização da rede e JCTs mais rápidos. Do ponto de vista da carga de trabalho de IA, isso resulta em melhor desempenho da carga de trabalho de IA e maior utilização de GPUs caras.

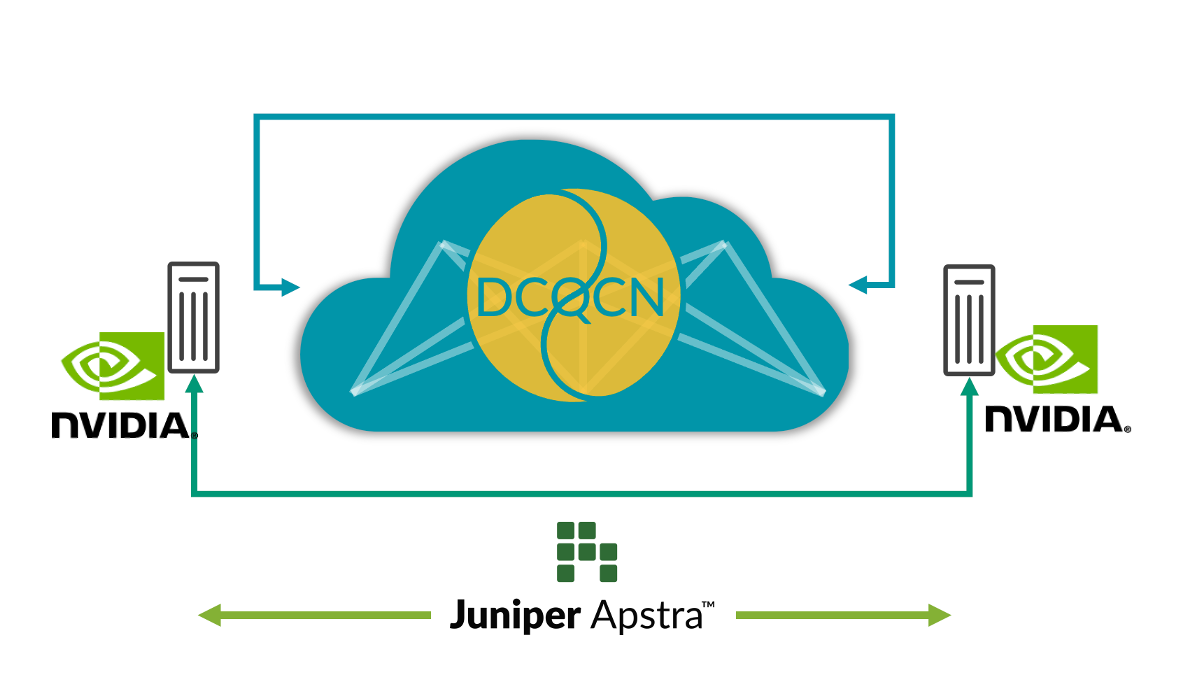

Visibilidade de ponta a ponta da rede para SmartNICs

Hoje, os administradores podem descobrir onde ocorre o congestionamento observando apenas os switches de rede. Mas eles não têm visibilidade sobre quais endpoints (GPUs, no caso de data centers com IA) são afetados pelo congestionamento. Isso leva a desafios na identificação e resolução de problemas de desempenho. Em um ambiente de trabalho com vários treinamentos, apenas observando a telemetria do switch, é impossível descobrir quais trabalhos de treinamento ficaram lentos devido ao congestionamento sem verificar manualmente as estatísticas do NIC RoCE v2 em todos os servidores, e não há praticidade nisso.

Para resolver o problema, a integração da telemetria de streaming avançada RoCE v2 dos SmartNICs do servidor de IA com o Juniper Apstra e a correlação da telemetria do switch de rede existente aprimoram muito a observabilidade e os fluxos de trabalho de depuração quando ocorrem problemas de desempenho. Esta correlação permite uma visão mais holística da rede e uma melhor compreensão das relações entre os servidores de IA e os comportamentos da rede. Os dados em tempo real fornecem insights sobre o desempenho da rede, padrões de tráfego, possíveis pontos de congestionamento e endpoints afetados, ajudando a identificar gargalos e anomalias de desempenho.

Esse recurso melhora a observabilidade da rede, simplifica a depuração de problemas de desempenho e ajuda a melhorar o desempenho geral da rede por meio de ações em loop fechado. Por exemplo, monitorar pacotes fora de ordem nos SmartNICs pode ajudar a ajustar os parâmetros no recurso de balanceamento de carga inteligente no switch. Dessa forma, a visibilidade de ponta a ponta pode ajudar os usuários a executar a infraestrutura de IA com desempenho máximo.

Figura 3: Visibilidade E2E da rede para SmartNICs

Para saber mais, não deixe de participar do “Seize the AI Moment”, nosso evento on-line, no dia 23 de julho, onde contamos com uma lista de importantes clientes da Juniper e grandes nomes do setor para falar sobre o que aprenderam no mundo em rápido desenvolvimento da Infraestrutura de data center com IA.

Declaração de direção de produtos. A Juniper Networks pode divulgar informações relacionadas ao desenvolvimento e planos para produtos, recursos ou melhorias futuras, conhecidas como Declaração de Direção do Produto ou Plano de Registro (“POR”). Esses detalhes fornecidos baseiam-se nos esforços e nos planos atuais de desenvolvimento da Juniper. Esses esforços e planos de desenvolvimento estão sujeitos a alterações a critério exclusivo da Juniper, sem aviso prévio. Exceto conforme estabelecido em um contrato definitivo, a Juniper Networks não oferece garantias e não assume nenhuma responsabilidade pelo lançamento de produtos, recursos ou melhorias descritos neste site, apresentação, reunião ou publicação, nem a Juniper é responsável por qualquer perda decorrente da confiança no POR. As decisões de compra de terceiros não devem ser baseadas neste POR, e nenhuma compra depende da entrega pela Juniper Networks de qualquer recurso ou funcionalidade descrita neste site, apresentação, reunião ou publicação.